parent

334a85fd1c

commit

68da912b4e

@ -0,0 +1,353 @@ |

||||

# MAC/iOS利用FFmpeg解析音视频数据流 |

||||

|

||||

## 1.简易流程 |

||||

|

||||

**使用流程** |

||||

|

||||

- 初始化解析类: `- (instancetype)initWithPath:(NSString *)path;` |

||||

- 开始解析: `startParseWithCompletionHandler` |

||||

- 获取解析后的数据: 从上一步中`startParseWithCompletionHandler`方法中的Block获取解析后的音视频数据. |

||||

|

||||

**FFmpeg parse流程** |

||||

|

||||

- 创建format context: `avformat_alloc_context` |

||||

- 打开文件流: `avformat_open_input` |

||||

- 寻找流信息: `avformat_find_stream_info` |

||||

- 获取音视频流的索引值: `formatContext->streams[i]->codecpar->codec_type == (isVideoStream ? AVMEDIA_TYPE_VIDEO : AVMEDIA_TYPE_AUDIO)` |

||||

- 获取音视频流: `m_formatContext->streams[m_audioStreamIndex]` |

||||

- 解析音视频数据帧: `av_read_frame` |

||||

- 获取extra data: `av_bitstream_filter_filter` |

||||

|

||||

具体步骤 |

||||

|

||||

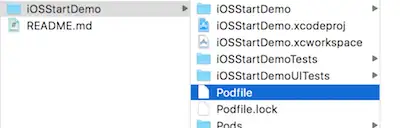

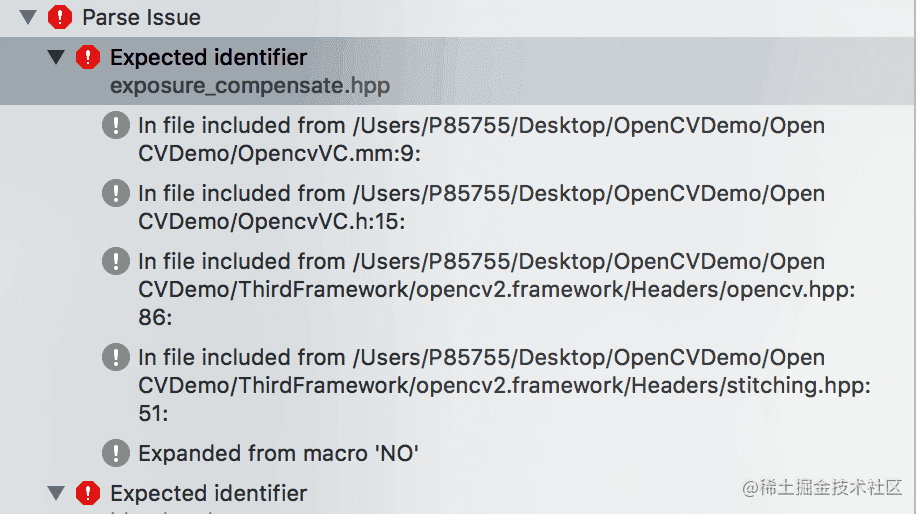

\1. 将FFmpeg框架导入项目中 |

||||

下面的链接中包含搭建iOS需要的FFmpeg环境的详细步骤,需要的可以提前阅读. |

||||

[iOS编译FFmpeg](https://zhuanlan.zhihu.com/p/533700525) |

||||

导入FFmpeg框架后,首先需要将用到FFmpeg的文件改名为`.mm`, 因为涉及C,C++混编,所以需要更改文件名 |

||||

然后在头文件中导入FFmpeg头文件. |

||||

|

||||

```text |

||||

// FFmpeg Header File |

||||

#ifdef __cplusplus |

||||

extern "C" { |

||||

#endif |

||||

|

||||

#include "libavformat/avformat.h" |

||||

#include "libavcodec/avcodec.h" |

||||

#include "libavutil/avutil.h" |

||||

#include "libswscale/swscale.h" |

||||

#include "libswresample/swresample.h" |

||||

#include "libavutil/opt.h" |

||||

|

||||

#ifdef __cplusplus |

||||

}; |

||||

#endif |

||||

``` |

||||

|

||||

注意: FFmpeg是一个广为流传的框架,其结构复杂,一般导入都按照如上格式,以文件夹名为根目录进行导入,具体设置,请参考上文链接. |

||||

|

||||

## 2. 初始化 |

||||

|

||||

### **2.1. 注册FFmpeg** |

||||

|

||||

- `void av_register_all(void);` 初始化libavformat并注册所有muxers,demuxers与协议。如果不调用此功能,则可以选择一个特定想要支持的格式。 |

||||

|

||||

一般在程序中的main函数或是主程序启动的代理方法`- (BOOL)application:(UIApplication *)application didFinishLaunchingWithOptions:(NSDictionary *)launchOptions`中初始化FFmpeg,执行一次即可. |

||||

|

||||

```text |

||||

av_register_all(); |

||||

``` |

||||

|

||||

### **2.2. 利用视频文件生成格式上下文对象** |

||||

|

||||

- `avformat_alloc_context()`: 初始化avformat上下文对象. |

||||

|

||||

- `int avformat_open_input(AVFormatContext **ps, const char *url, AVInputFormat *fmt, AVDictionary **options)`函数 |

||||

|

||||

- - `fmt`: 如果非空表示强制指定一个输入流的格式, 设置为空会自动选择. |

||||

|

||||

- `int avformat_find_stream_info(AVFormatContext *ic, AVDictionary **options);` :读取媒体文件的数据包以获取流信息 |

||||

|

||||

```text |

||||

- (AVFormatContext *)createFormatContextbyFilePath:(NSString *)filePath { |

||||

if (filePath == nil) { |

||||

log4cplus_error(kModuleName, "%s: file path is NULL",__func__); |

||||

return NULL; |

||||

} |

||||

|

||||

AVFormatContext *formatContext = NULL; |

||||

AVDictionary *opts = NULL; |

||||

|

||||

av_dict_set(&opts, "timeout", "1000000", 0);//设置超时1秒 |

||||

|

||||

formatContext = avformat_alloc_context(); |

||||

BOOL isSuccess = avformat_open_input(&formatContext, [filePath cStringUsingEncoding:NSUTF8StringEncoding], NULL, &opts) < 0 ? NO : YES; |

||||

av_dict_free(&opts); |

||||

if (!isSuccess) { |

||||

if (formatContext) { |

||||

avformat_free_context(formatContext); |

||||

} |

||||

return NULL; |

||||

} |

||||

|

||||

if (avformat_find_stream_info(formatContext, NULL) < 0) { |

||||

avformat_close_input(&formatContext); |

||||

return NULL; |

||||

} |

||||

|

||||

return formatContext; |

||||

} |

||||

``` |

||||

|

||||

### **2.3. 获取Audio / Video流的索引值.** |

||||

|

||||

通过遍历format context对象可以从`nb_streams`数组中找到音频或视频流索引,以便后续使用 |

||||

|

||||

注意: 后面代码中仅需要知道音频,视频的索引就可以快速读取到format context对象中对应流的信息. |

||||

|

||||

```text |

||||

- (int)getAVStreamIndexWithFormatContext:(AVFormatContext *)formatContext isVideoStream:(BOOL)isVideoStream { |

||||

int avStreamIndex = -1; |

||||

for (int i = 0; i < formatContext->nb_streams; i++) { |

||||

if ((isVideoStream ? AVMEDIA_TYPE_VIDEO : AVMEDIA_TYPE_AUDIO) == formatContext->streams[i]->codecpar->codec_type) { |

||||

avStreamIndex = i; |

||||

} |

||||

} |

||||

|

||||

if (avStreamIndex == -1) { |

||||

log4cplus_error(kModuleName, "%s: Not find video stream",__func__); |

||||

return NULL; |

||||

}else { |

||||

return avStreamIndex; |

||||

} |

||||

} |

||||

``` |

||||

|

||||

### **2.4. 是否支持音视频流** |

||||

|

||||

目前视频仅支持H264, H265编码的格式.实际过程中,解码得到视频的旋转角度可能是不同的,以及不同机型可以支持的解码文件格式也是不同的,所以可以用这个方法手动过滤一些不支持的情况.具体请下载代码观看,这里仅列出实战中测试出支持的列表. |

||||

|

||||

```text |

||||

/* |

||||

各机型支持的最高分辨率和FPS组合: |

||||

|

||||

iPhone 6S: 60fps -> 720P |

||||

30fps -> 4K |

||||

|

||||

iPhone 7P: 60fps -> 1080p |

||||

30fps -> 4K |

||||

|

||||

iPhone 8: 60fps -> 1080p |

||||

30fps -> 4K |

||||

|

||||

iPhone 8P: 60fps -> 1080p |

||||

30fps -> 4K |

||||

|

||||

iPhone X: 60fps -> 1080p |

||||

30fps -> 4K |

||||

|

||||

iPhone XS: 60fps -> 1080p |

||||

30fps -> 4K |

||||

*/ |

||||

``` |

||||

|

||||

音频本例中仅支持AAC格式.其他格式可根据需求自行更改. |

||||

|

||||

## 3. 开始解析 |

||||

|

||||

- 初始化AVPacket以存放解析后的数据 |

||||

|

||||

使用AVPacket这个结构体来存储压缩数据.对于视频而言, 它通常包含一个压缩帧,对音频而言,可能包含多个压缩帧,该结构体类型通过`av_malloc()`函数分配内存,通过`av_packet_ref()`函数拷贝,通过`av_packet_unref().`函数释放内存. |

||||

|

||||

```text |

||||

AVPacket packet; |

||||

av_init_packet(&packet); |

||||

``` |

||||

|

||||

解析数据 |

||||

`int av_read_frame(AVFormatContext *s, AVPacket *pkt);` : 此函数返回存储在文件中的内容,并且不验证解码器的有效帧是什么。它会将存储在文件中的内容分成帧,并为每次调用返回一个。它不会在有效帧之间省略无效数据,以便为解码器提供解码时可能的最大信息。 |

||||

|

||||

```text |

||||

int size = av_read_frame(formatContext, &packet); |

||||

if (size < 0 || packet.size < 0) { |

||||

handler(YES, YES, NULL, NULL); |

||||

log4cplus_error(kModuleName, "%s: Parse finish",__func__); |

||||

break; |

||||

} |

||||

``` |

||||

|

||||

获取sps, pps等NALU Header信息 |

||||

通过调用`av_bitstream_filter_filter`可以从码流中过滤得到sps, pps等NALU Header信息. |

||||

av_bitstream_filter_init: 通过给定的比特流过滤器名词创建并初始化一个比特流过滤器上下文. |

||||

av_bitstream_filter_filter: 此函数通过过滤`buf`参数中的数据,将过滤后的数据放在`poutbuf`参数中.输出的buffer必须被调用者释放. |

||||

此函数使用buf_size大小过滤缓冲区buf,并将过滤后的缓冲区放在poutbuf指向的缓冲区中。 |

||||

|

||||

```text |

||||

attribute_deprecated int av_bitstream_filter_filter ( AVBitStreamFilterContext * bsfc, |

||||

AVCodecContext * avctx, |

||||

const char * args, // filter 配置参数 |

||||

uint8_t ** poutbuf, // 过滤后的数据 |

||||

int * poutbuf_size, // 过滤后的数据大小 |

||||

const uint8_t * buf,// 提供给过滤器的原始数据 |

||||

int buf_size, // 提供给过滤器的原始数据大小 |

||||

int keyframe // 如果要过滤的buffer对应于关键帧分组数据,则设置为非零 |

||||

) |

||||

``` |

||||

|

||||

注意: 下面使用`new_packet`是为了解决`av_bitstream_filter_filter`会产生内存泄漏的问题.每次使用完后将用`new_packet`释放即可. |

||||

|

||||

```text |

||||

if (packet.stream_index == videoStreamIndex) { |

||||

static char filter_name[32]; |

||||

if (formatContext->streams[videoStreamIndex]->codecpar->codec_id == AV_CODEC_ID_H264) { |

||||

strncpy(filter_name, "h264_mp4toannexb", 32); |

||||

videoInfo.videoFormat = XDXH264EncodeFormat; |

||||

} else if (formatContext->streams[videoStreamIndex]->codecpar->codec_id == AV_CODEC_ID_HEVC) { |

||||

strncpy(filter_name, "hevc_mp4toannexb", 32); |

||||

videoInfo.videoFormat = XDXH265EncodeFormat; |

||||

} else { |

||||

break; |

||||

} |

||||

|

||||

AVPacket new_packet = packet; |

||||

if (self->m_bitFilterContext == NULL) { |

||||

self->m_bitFilterContext = av_bitstream_filter_init(filter_name); |

||||

} |

||||

av_bitstream_filter_filter(self->m_bitFilterContext, formatContext->streams[videoStreamIndex]->codec, NULL, &new_packet.data, &new_packet.size, packet.data, packet.size, 0); |

||||

|

||||

} |

||||

``` |

||||

|

||||

- 根据特定规则生成时间戳 |

||||

|

||||

可以根据自己的需求自定义时间戳生成规则.这里使用当前系统时间戳加上数据包中的自带的pts/dts生成了时间戳. |

||||

|

||||

```text |

||||

CMSampleTimingInfo timingInfo; |

||||

CMTime presentationTimeStamp = kCMTimeInvalid; |

||||

presentationTimeStamp = CMTimeMakeWithSeconds(current_timestamp + packet.pts * av_q2d(formatContext->streams[videoStreamIndex]->time_base), fps); |

||||

timingInfo.presentationTimeStamp = presentationTimeStamp; |

||||

timingInfo.decodeTimeStamp = CMTimeMakeWithSeconds(current_timestamp + av_rescale_q(packet.dts, formatContext->streams[videoStreamIndex]->time_base, input_base), fps); |

||||

``` |

||||

|

||||

- 获取parse到的数据 |

||||

|

||||

本例将获取到的数据放在自定义的结构体中,然后通过block回调传给方法的调用者,调用者可以在回调函数中处理parse到的视频数据. |

||||

|

||||

```text |

||||

struct XDXParseVideoDataInfo { |

||||

uint8_t *data; |

||||

int dataSize; |

||||

uint8_t *extraData; |

||||

int extraDataSize; |

||||

Float64 pts; |

||||

Float64 time_base; |

||||

int videoRotate; |

||||

int fps; |

||||

CMSampleTimingInfo timingInfo; |

||||

XDXVideoEncodeFormat videoFormat; |

||||

}; |

||||

|

||||

... |

||||

|

||||

videoInfo.data = video_data; |

||||

videoInfo.dataSize = video_size; |

||||

videoInfo.extraDataSize = formatContext->streams[videoStreamIndex]->codec->extradata_size; |

||||

videoInfo.extraData = (uint8_t *)malloc(videoInfo.extraDataSize); |

||||

videoInfo.timingInfo = timingInfo; |

||||

videoInfo.pts = packet.pts * av_q2d(formatContext->streams[videoStreamIndex]->time_base); |

||||

videoInfo.fps = fps; |

||||

|

||||

memcpy(videoInfo.extraData, formatContext->streams[videoStreamIndex]->codec->extradata, videoInfo.extraDataSize); |

||||

av_free(new_packet.data); |

||||

|

||||

// send videoInfo |

||||

if (handler) { |

||||

handler(YES, NO, &videoInfo, NULL); |

||||

} |

||||

|

||||

free(videoInfo.extraData); |

||||

free(videoInfo.data); |

||||

``` |

||||

|

||||

获取parse到的音频数据 |

||||

|

||||

```text |

||||

struct XDXParseAudioDataInfo { |

||||

uint8_t *data; |

||||

int dataSize; |

||||

int channel; |

||||

int sampleRate; |

||||

Float64 pts; |

||||

}; |

||||

|

||||

... |

||||

|

||||

if (packet.stream_index == audioStreamIndex) { |

||||

XDXParseAudioDataInfo audioInfo = {0}; |

||||

audioInfo.data = (uint8_t *)malloc(packet.size); |

||||

memcpy(audioInfo.data, packet.data, packet.size); |

||||

audioInfo.dataSize = packet.size; |

||||

audioInfo.channel = formatContext->streams[audioStreamIndex]->codecpar->channels; |

||||

audioInfo.sampleRate = formatContext->streams[audioStreamIndex]->codecpar->sample_rate; |

||||

audioInfo.pts = packet.pts * av_q2d(formatContext->streams[audioStreamIndex]->time_base); |

||||

|

||||

// send audio info |

||||

if (handler) { |

||||

handler(NO, NO, NULL, &audioInfo); |

||||

} |

||||

|

||||

free(audioInfo.data); |

||||

} |

||||

``` |

||||

|

||||

- 释放packet |

||||

|

||||

因为我们已经将packet中的关键数据拷贝到自定义的结构体中,所以使用完后需要释放packet. |

||||

|

||||

```text |

||||

av_packet_unref(&packet); |

||||

``` |

||||

|

||||

parse完成后释放相关资源 |

||||

|

||||

```text |

||||

- (void)freeAllResources { |

||||

if (m_formatContext) { |

||||

avformat_close_input(&m_formatContext); |

||||

m_formatContext = NULL; |

||||

} |

||||

|

||||

if (m_bitFilterContext) { |

||||

av_bitstream_filter_close(m_bitFilterContext); |

||||

m_bitFilterContext = NULL; |

||||

} |

||||

} |

||||

``` |

||||

|

||||

注意: 如果使用FFmpeg硬解,则仅仅需要获取到AVPacket数据结构即可.不需要再将数据封装到自定义的结构体中 |

||||

|

||||

## 4. 外部调用 |

||||

|

||||

上面操作执行完后,即可通过如下block获取解析后的数据,一般需要继续对音视频进行解码操作.后面文章会讲到,请持续关注. |

||||

|

||||

```text |

||||

XDXAVParseHandler *parseHandler = [[XDXAVParseHandler alloc] initWithPath:path]; |

||||

[parseHandler startParseGetAVPackeWithCompletionHandler:^(BOOL isVideoFrame, BOOL isFinish, AVPacket packet) { |

||||

if (isFinish) { |

||||

// parse finish |

||||

... |

||||

return; |

||||

} |

||||

|

||||

if (isVideoFrame) { |

||||

// decode video |

||||

... |

||||

}else { |

||||

// decode audio |

||||

... |

||||

} |

||||

}]; |

||||

``` |

||||

|

||||

原文https://zhuanlan.zhihu.com/p/533710513 |

||||

@ -0,0 +1,161 @@ |

||||

# iOS - 图形高级处理 (一、图片显示相关理论) |

||||

|

||||

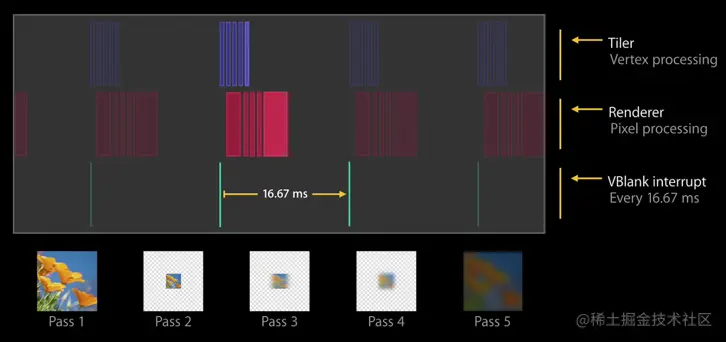

## 1、图片从磁盘中读入到显示到屏幕全过程 |

||||

|

||||

### 1.1图片的加载过程: |

||||

|

||||

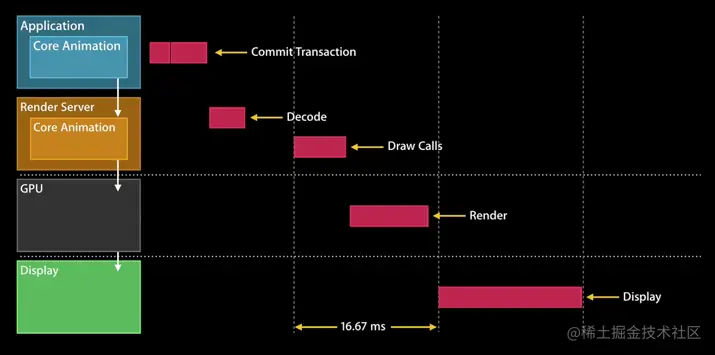

- 使用 +imageWithContentsOfFile: 方法从磁盘中加载一张图片或 -[UIImage imageNamed:@"xx.JPG"]此时图片并没有解码;([两种方式的区别](https://link.juejin.cn?target=http%3A%2F%2Fwww.cocoachina.com%2Farticles%2F26556)) |

||||

|

||||

- 初始化完成的UITmage 赋值给 UIImageView; |

||||

|

||||

- 接着一个隐式的 CATransaction 捕获到了 UIImageView 图层树的变化; |

||||

|

||||

- 在主线程的下一个 runloop 到来时,Core Animation 提交了这个隐式的 transaction ,这个过程可能会对图片进行 copy 操作,而受图片是否字节对齐等因素的影响,这个 copy 操作可能会涉及以下部分或全部步骤: |

||||

|

||||

- 分配内存缓冲区用于管理文件 IO 和解压缩操作; |

||||

- 将文件数据从磁盘读到内存中; |

||||

- 将压缩的图片数据解码成未压缩的位图形式,这是一个非常耗时的 CPU 操作; |

||||

- 最后 Core Animation 中CALayer使用未压缩的位图数据渲染 UIImageView 的图层。 |

||||

- CPU计算好图片的Frame,对图片解压之后.就会交给GPU来做图片渲染。 |

||||

|

||||

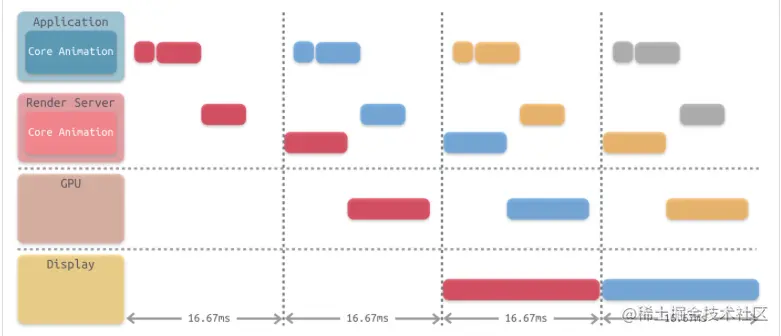

由上面的步骤可知,图片的解压缩是一个非常耗时的 CPU 操作,并且它默认是在主线程中执行的。那么当需要加载的图片比较多时,就会对我们应用的响应性造成严重的影响,尤其是在快速滑动的列表上,这个问题会表现得更加突出。 |

||||

|

||||

### 1.2渲染图片到屏幕上 |

||||

|

||||

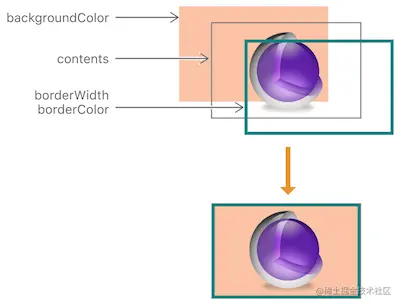

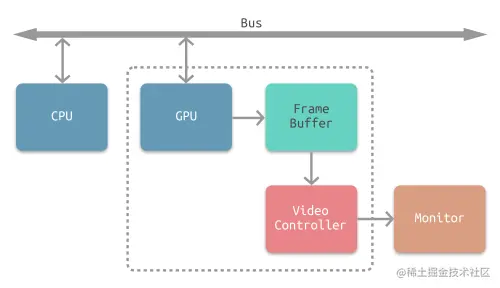

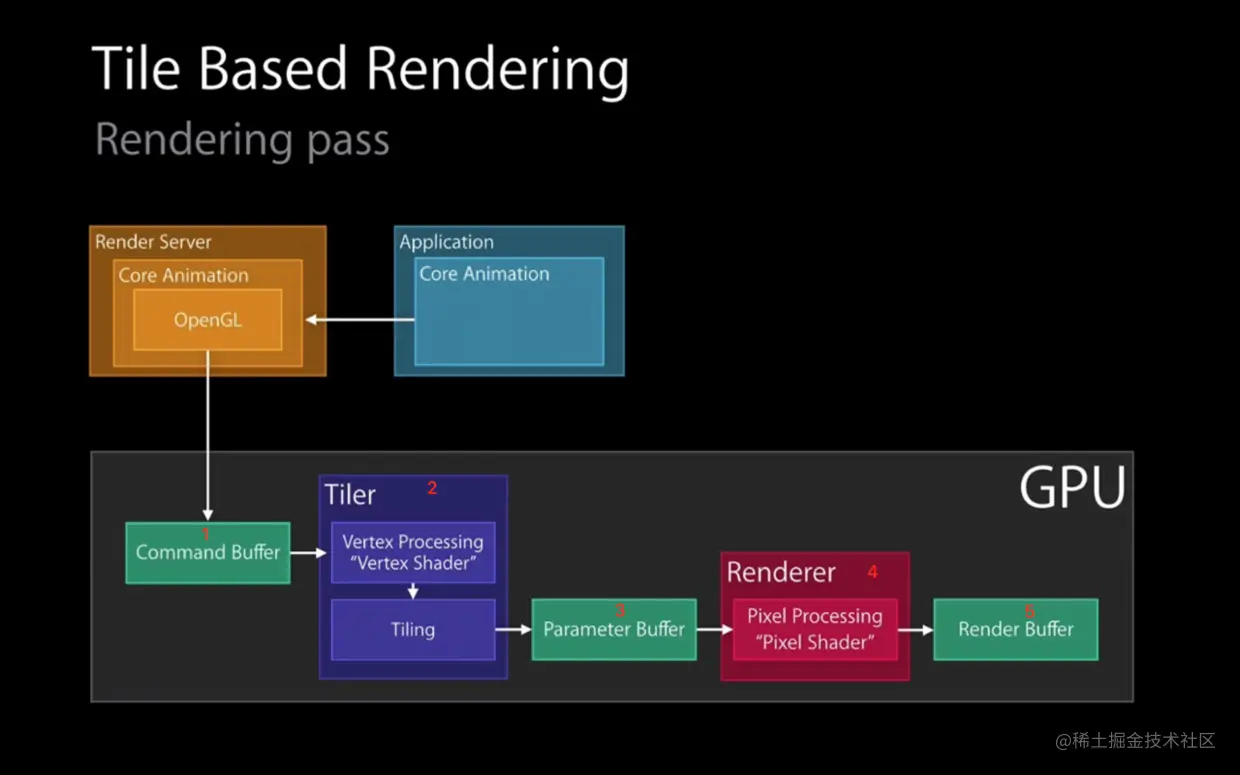

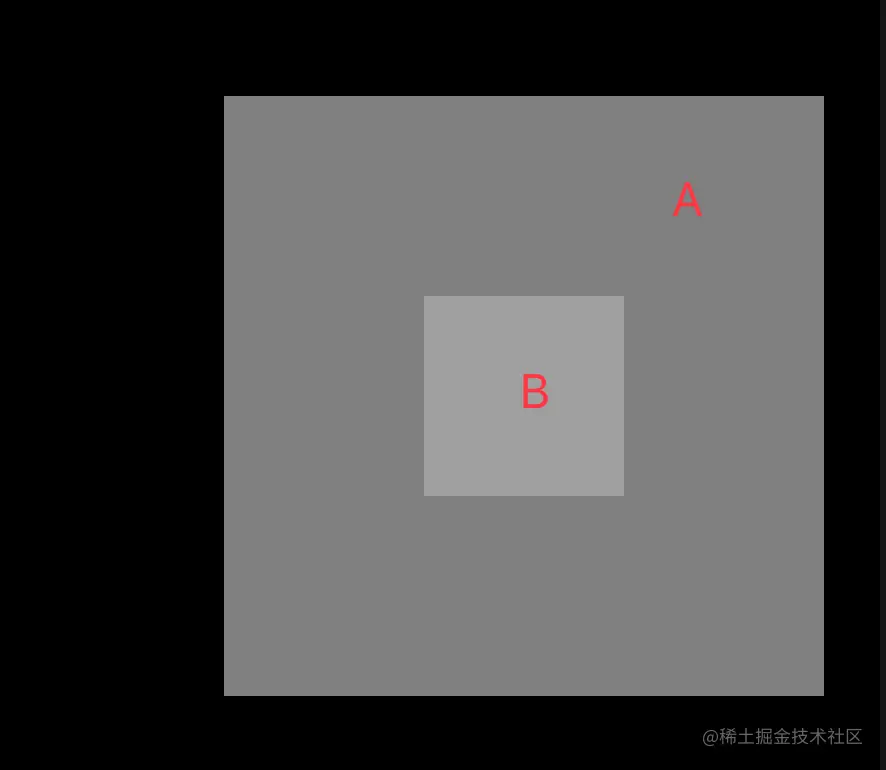

- iOS设备给用户视觉反馈其实都是通过QuartzCore框架来进行的,说白了,所有用户最终看到的显示界面都是图层合成的结果,而图层即是QuartzCore中的CALayer。 |

||||

- 通常我们开发中使用的视图即UIView,他并不是直接显示在屏幕上的,你可以把他想象成一个装有显示层CALayer的容器。我们在在创建视图对象的时候,系统会自动为该视图创建一个CALayer;当然我们也可以自己再往该视图中加入新的CALayer层。等到需要显示的时候,系统硬件将把所有层进行拷贝,然后按Z轴的高低合成最终的合成效果。  |

||||

|

||||

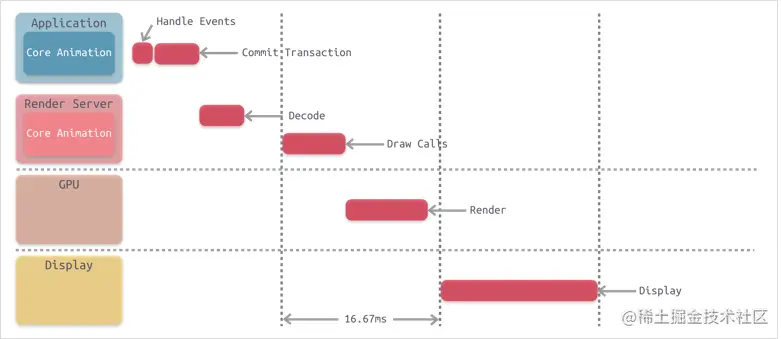

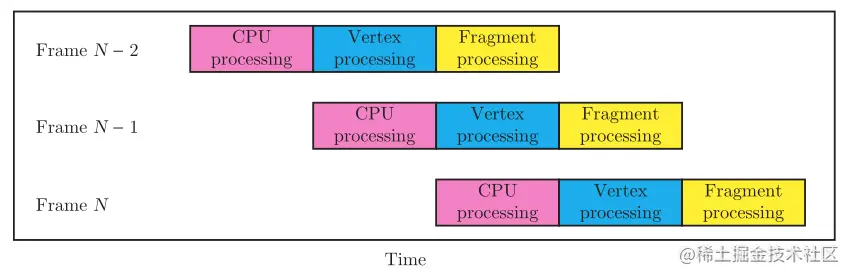

### 1.3图片渲染大致流程 |

||||

|

||||

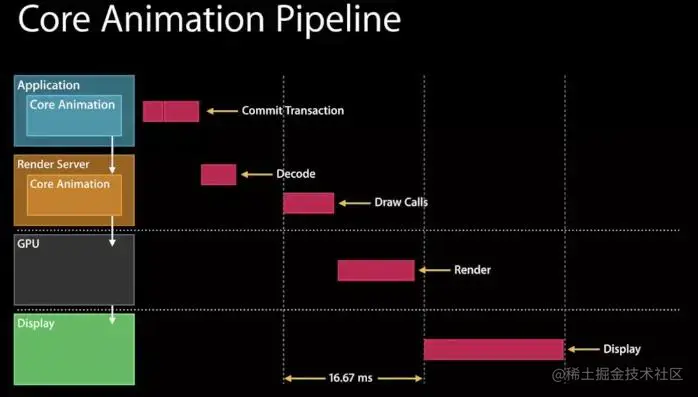

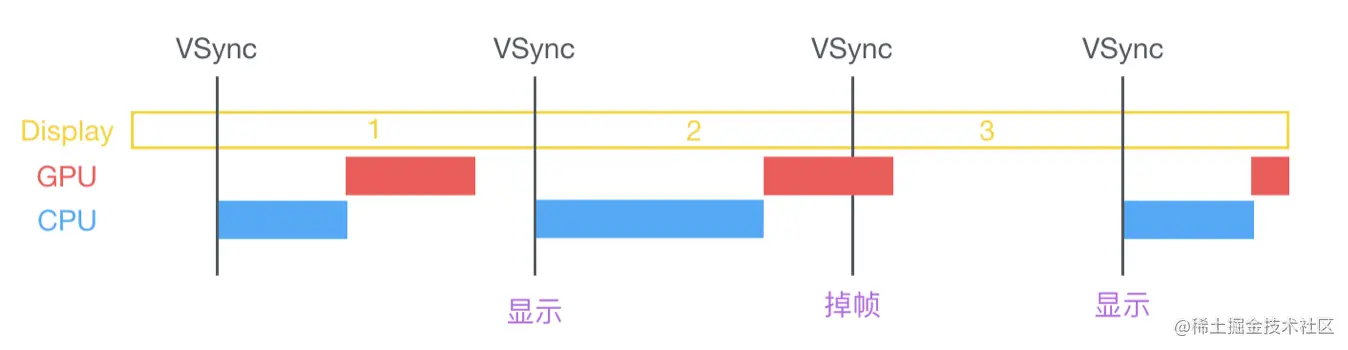

- 在 VSync 信号到来后,主线程开始在cpu上做计算。 |

||||

- CPU计算显示内容:视图创建、布局计算、图片解码、文本绘制等。 |

||||

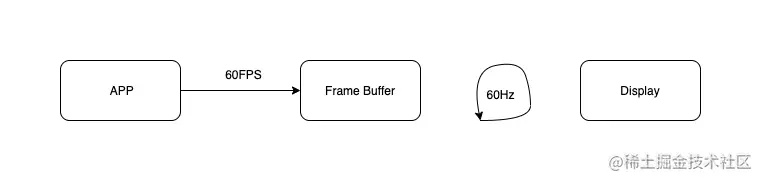

- GPU进行渲染:CPU将计算好的内容提交给GPU,GPU 进行变换、合成、渲染。 |

||||

- GPU 会把渲染结果提交到帧缓冲区去,等待下一次 VSync 信号到来时显示到屏幕上。 |

||||

|

||||

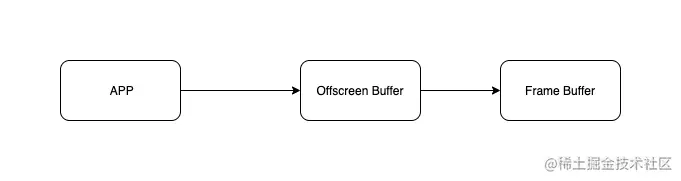

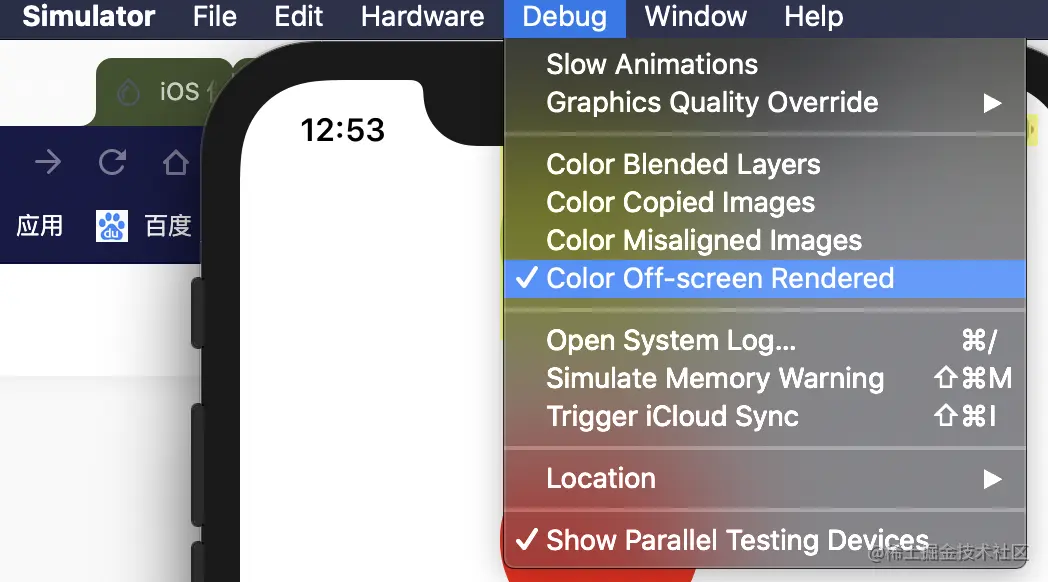

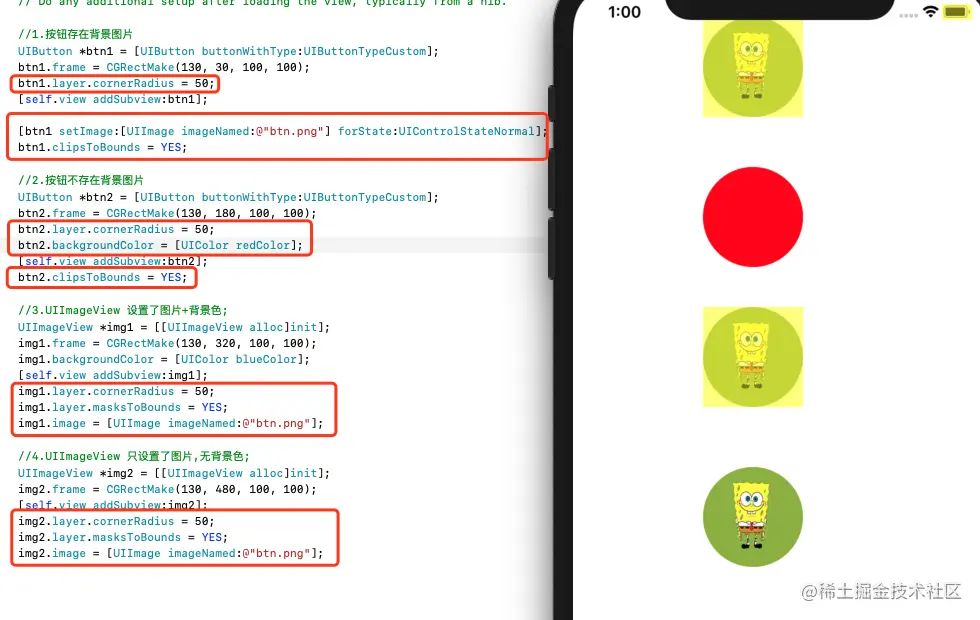

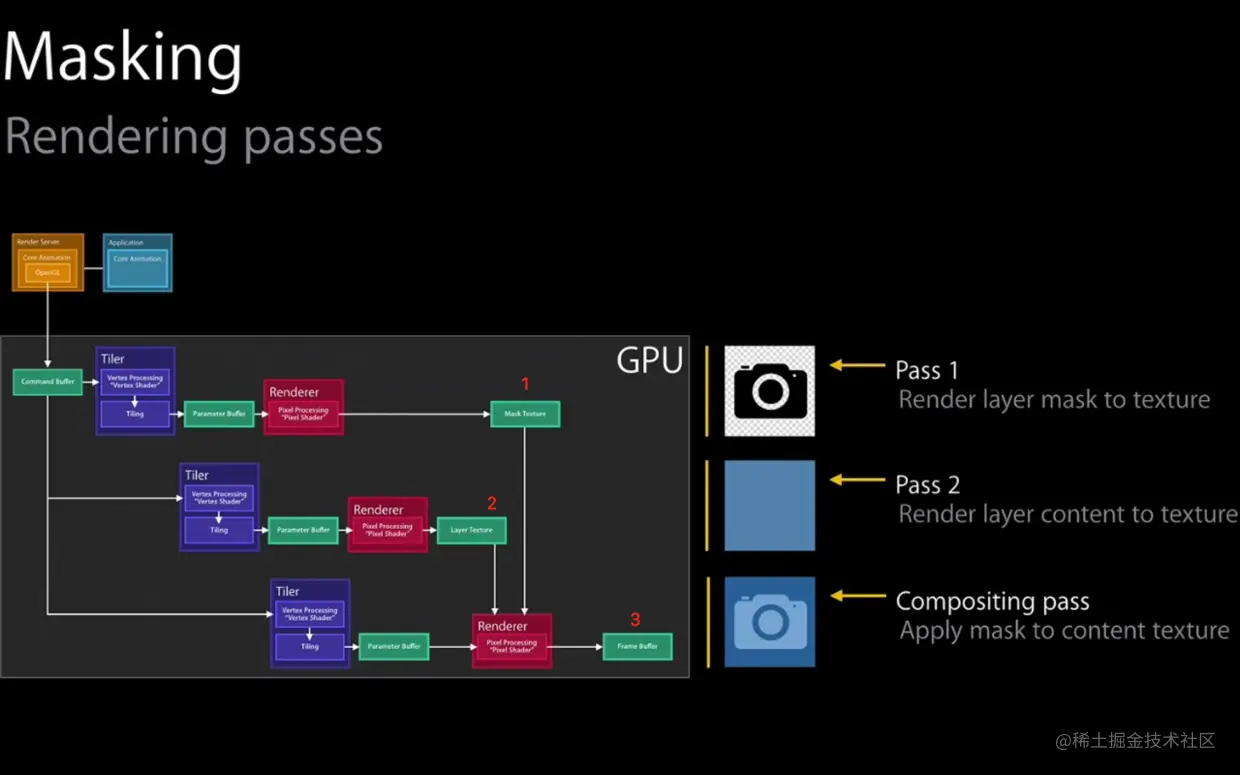

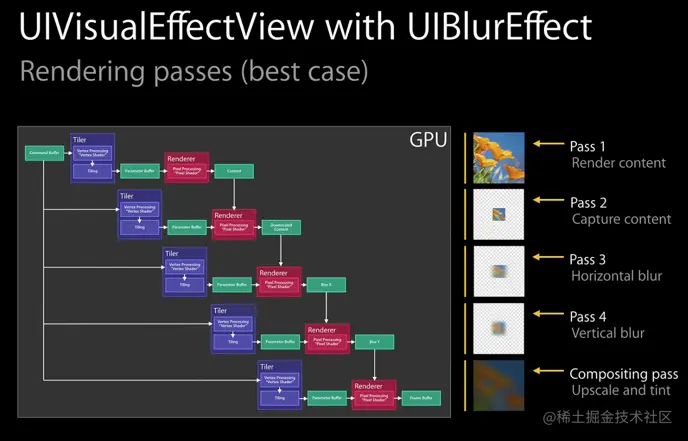

关于渲染更多知识点,例如离屏渲染等因为篇幅太长不利于学习,这部分放在后面app性能篇继续学习。 |

||||

|

||||

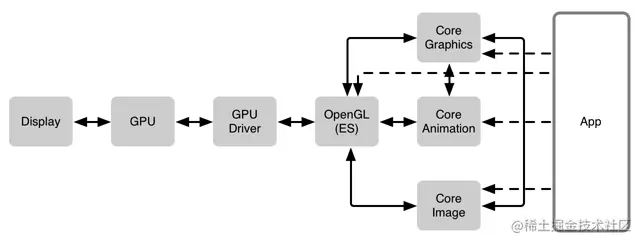

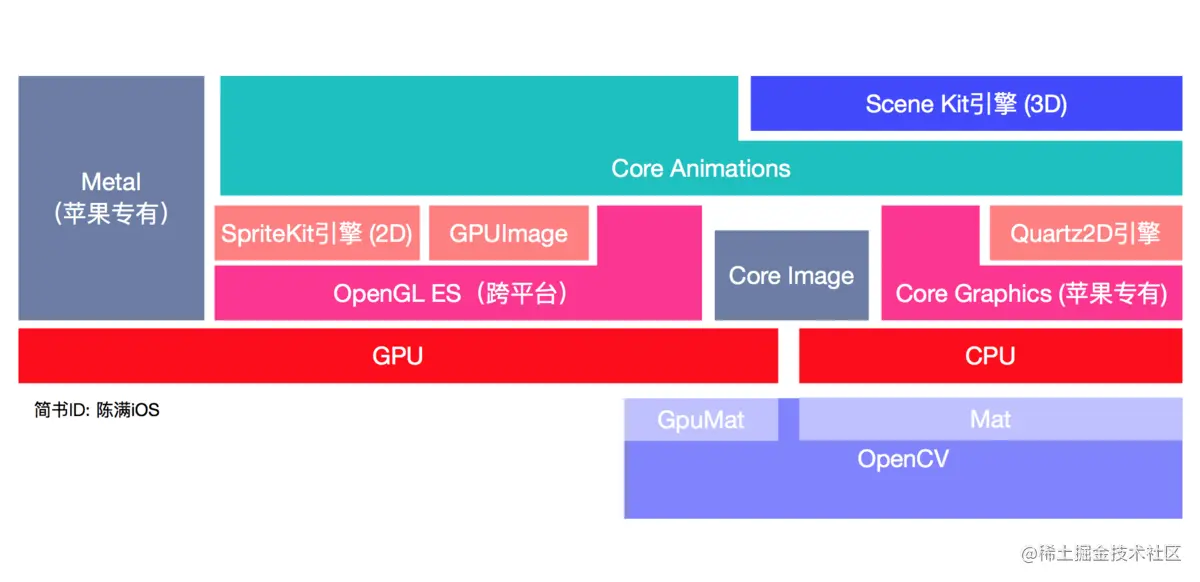

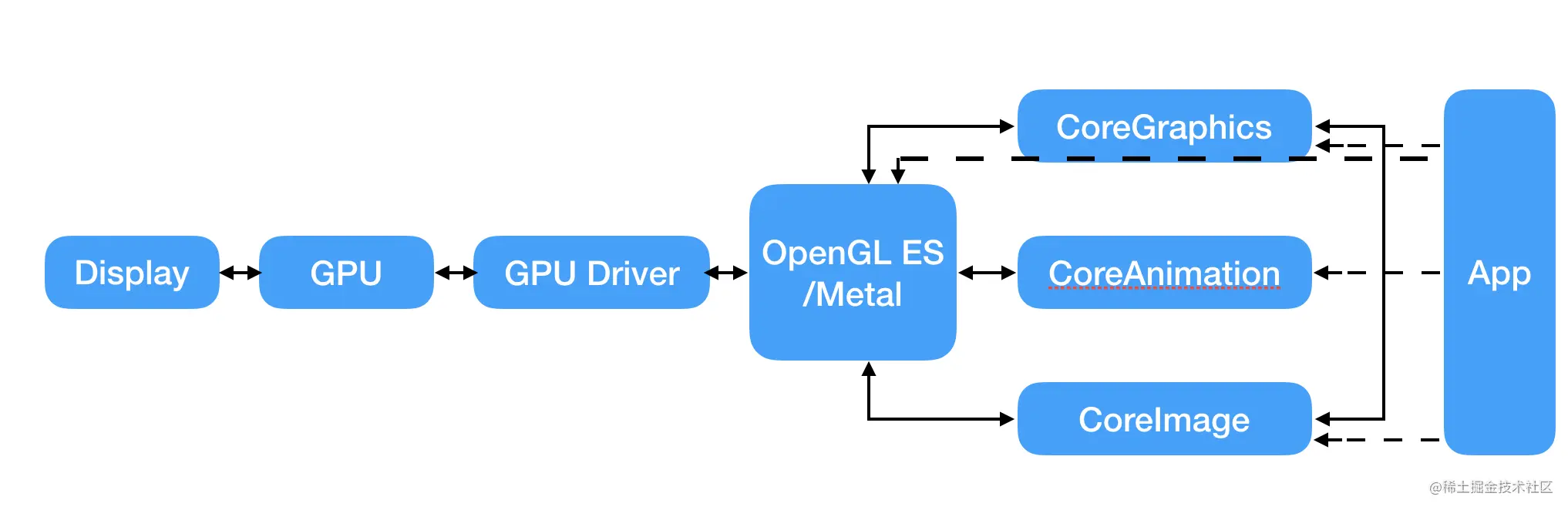

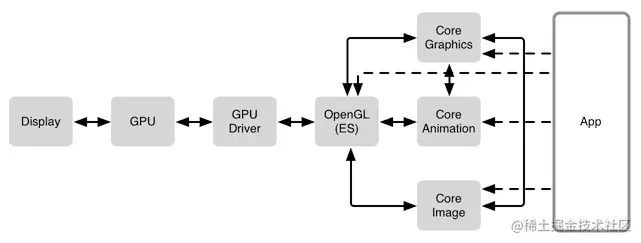

## 2、图形处理相关框架 |

||||

|

||||

通过以上图片加载显示的理论学习,我们就需要来继续学习一下图形处理的相关理论,毕竟在开发过程中我们无法,性能上也不允许,所有图片的显示都用UIimage从磁盘或内存中读入。同时一些界面显示也或多或少要使用到图形处理框架。  |

||||

|

||||

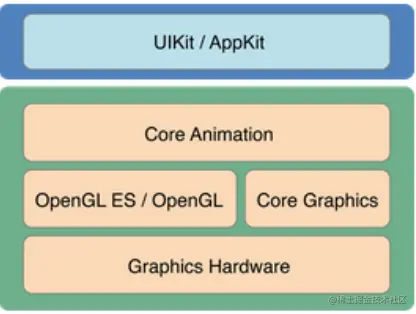

### 2.1iOS与图形图像处理相关的框架汇总: |

||||

|

||||

- 界面图形框架 -- UIKit |

||||

- 核心动画框架 -- Core Animation |

||||

- 苹果封装的图形框架 -- Core Graphics & Quartz 2D |

||||

- 传统跨平台图形框架 -- OpenGL ES |

||||

- 苹果最新力推的图形框架 -- Metal |

||||

- 适合图片的苹果滤镜框架 -- Core Image |

||||

- `适合视频的第三方滤镜方案 -- GPUImage (第三方不属于系统,这里列出来学习)` |

||||

- 游戏引擎 -- Scene Kit (3D) 和 Sprite Kit (2D) |

||||

- 计算机视觉在iOS的应用 -- OpenCV for iOS |

||||

|

||||

毫无疑问,开发者们接触得最多的框架是以下几个,UIKit、Core Animation,Core Graphic, Core Image。下面简要介绍这几个框架,顺便介绍下`GPUImage`: |

||||

|

||||

### 2.2界面图形框架 -- UIKit(穿插使用其他图形处理框架) |

||||

|

||||

- UIKit是一组Objective-C API,为线条图形、Quartz图像和颜色操作提供Objective-C 封装,并提供2D绘制、图像处理及用户接口级别的动画。 |

||||

|

||||

- UIKit包括UIBezierPath(绘制线、角度、椭圆及其它图形)、UIImage(显示图像)、UIColor(颜色操作)、UIFont和UIScreen(提供字体和屏幕信息)等类以及在位图图形环境、PDF图形环境上进行绘制和 操作的功能等, 也提供对标准视图的支持,也提供对打印功能的支持。 |

||||

|

||||

- UIKit与Core Graphics的关系: |

||||

|

||||

> 在UIKit中,UIView类本身在绘制时自动创建一个图形环境,即Core Graphics层的CGContext类型,作为当前的图形绘制环境。在绘制时可以调用 UIGraphicsGetCurrentContext 函数获得当前的图形环境; |

||||

|

||||

例如: |

||||

|

||||

> ```objectivec |

||||

> //这段代码就是在UIView的子类中调用 UIGraphicsGetCurrentContext 函数获得当前的图形环境,然后向该图形环境添加路径,最后绘制。 |

||||

> - (void)drawRect:(CGRect)rect { |

||||

> //1.获取上下文 |

||||

> CGContextRef contextRef = UIGraphicsGetCurrentContext(); |

||||

> //2.描述路径 |

||||

> UIBezierPath * path = [UIBezierPath bezierPath]; |

||||

> //起点 |

||||

> [path moveToPoint:CGPointMake(10, 10)]; |

||||

> //终点 |

||||

> [path addLineToPoint:CGPointMake(100, 100)]; |

||||

> //设置颜色 |

||||

> [[UIColor whiteColor]setStroke]; |

||||

> //3.添加路径 |

||||

> CGContextAddPath(contextRef, path.CGPath); |

||||

> //显示路径 |

||||

> CGContextStrokePath(contextRef); |

||||

> } |

||||

> 复制代码 |

||||

> ``` |

||||

|

||||

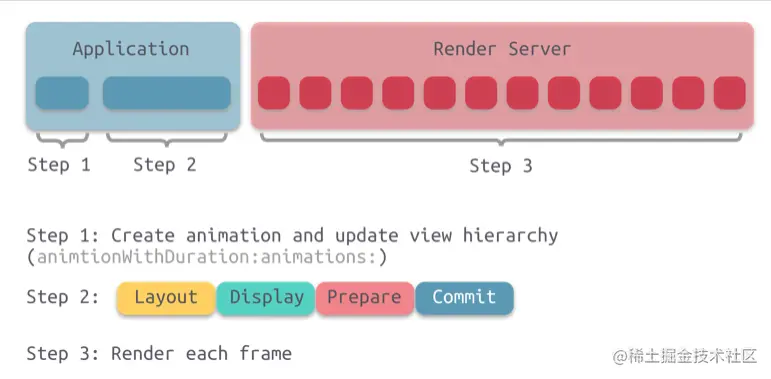

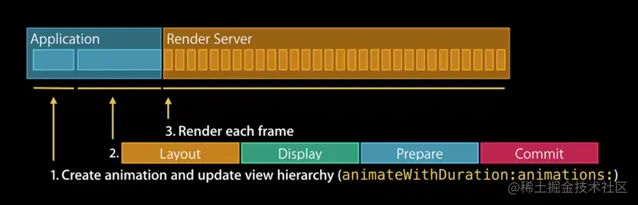

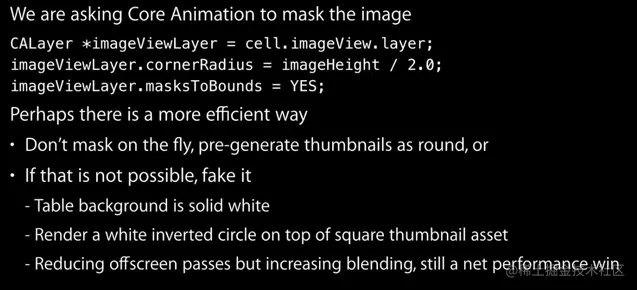

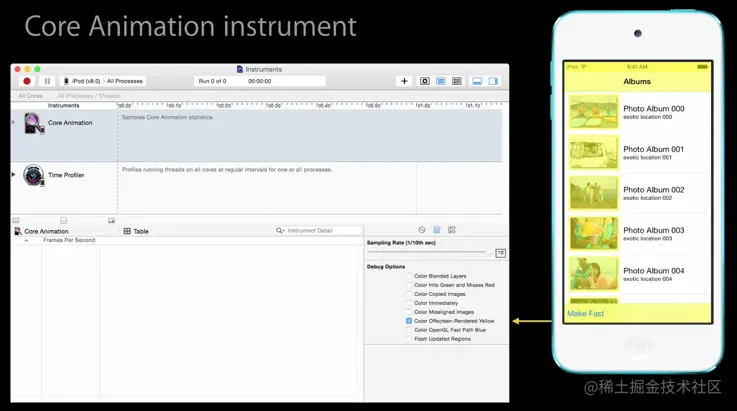

### 2.3核心动画框架 -- Core Animation |

||||

|

||||

- Core Animation 是常用的框架之一。它比 UIKit 和 AppKit 更底层。正如我们所知,UIView底下封装了一层CALayer树,Core Animation 层是真正的渲染层,我们之所以能在屏幕上看到内容,真正的渲染工作是在 Core Animation 层进行的。 |

||||

- Core Animation 是一套Objective-C API,实现了一个高性能的复合引擎,并提供一个简单易用的编程接口,给用户UI添加平滑运动和动态反馈能力。 |

||||

- Core Animation 是 UIKit 实现动画和变换的基础,也负责视图的复合功能。使用Core Animation可以实现定制动画和细粒度的动画控制,创建复杂的、支持动画和变换的layered 2D视图 |

||||

- OpenGL ES的内容也可以与Core Animation内容进行集成。 |

||||

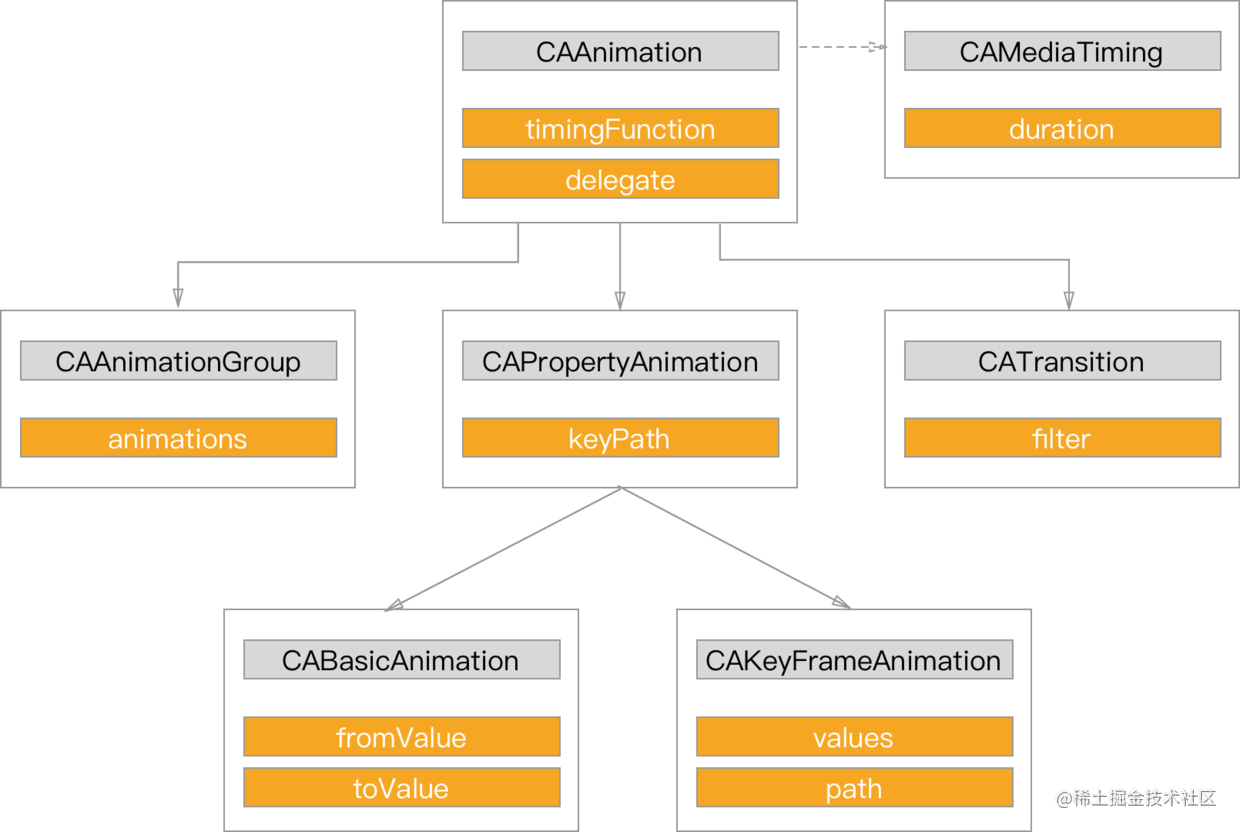

- 为了使用Core Animation实现动画,可以修改 层的属性值 来触发一个action对象的执行,不同的action对象实现不同的动画。Core Animation 提供了一组基类及子类,提供对不同动画类型的支持: |

||||

- CAAnimation 是一个抽象公共基类,CAAnimation采用CAMediaTiming 和CAAction协议为动画提供时间(如周期、速度、重复次数等)和action行为(启动、停止等)。 |

||||

- CAPropertyAnimation 是 CAAnimation的抽象子类,为动画提供一个由一个key路径规定的层属性的支持; |

||||

- CABasicAnimation 是CAPropertyAnimation的具体子类,为一个层属性提供简单插入能力。 |

||||

- CAKeyframeAnimation 也是CAPropertyAnimation的具体子类,提供key帧动画支持。 |

||||

|

||||

### 2.4苹果封装的图形框架 -- Core Graphics & Quartz 2D |

||||

|

||||

- Core Graphics(使用Quartz 2D引擎) |

||||

- Core Graphics是一套C-based API, 支持向量图形,线、形状、图案、路径、剃度、位图图像和pdf 内容的绘制 |

||||

- Core Graphics 也是常用的框架之一。它用于运行时绘制图像。开发者们可以通过 Core Graphics 绘制路径、颜色。当开发者需要在运行时创建图像时,可以使用 Core Graphics 去绘制,运行时实时计算、绘制一系列图像帧来实现动画。与之相对的是运行前创建图像(例如从磁盘中或内存中已经创建好的UIImage图像)。 |

||||

- Quartz 2D |

||||

- Quartz 2D是Core Graphics中的2D 绘制呈现引擎。Quartz是资源和设备无关的,提供路径绘制,anti-aliased呈现,剃度填充图案,图像,透明绘制和透明层、遮蔽和阴影、颜色管理,坐标转换,字体、offscreen呈现、pdf文档创建、显示和分析等功能。 |

||||

- Quartz 2D能够与所有的图形和动画技术(如Core Animation, OpenGL ES, 和 UIKit 等)一起使用。Quartz 2D采用paint模式进行绘制。 |

||||

- Quartz 2D提供的主要类包括: |

||||

- CGContext:表示一个图形环境; |

||||

- CGPath:使用向量图形来创建路径,并能够填充和stroke; |

||||

- CGImage:用来表示位图; |

||||

- CGLayer:用来表示一个能够用于重复绘制和offscreen绘制的绘制层; |

||||

- CGPattern:用来表示Pattern,用于重复绘制; |

||||

- CGShading和 CGGradient:用于绘制剃度; |

||||

- CGColor 和 CGColorSpace;用来进行颜色和颜色空间管理; |

||||

- CGFont, 用于绘制文本; |

||||

- CGPDFContentStream、CGPDFScanner、CGPDFPage、CGPDFObject,CGPDFStream, CGPDFString等用来进行pdf文件的创建、解析和显示。 |

||||

|

||||

### 2.5适合图片的苹果滤镜框架 -- Core Image |

||||

|

||||

- Core Image 与 Core Graphics 恰恰相反,Core Graphics 用于在运行时创建图像,而 Core Image 是用来处理已经创建的图像的。Core Image 框架拥有一系列现成的图像过滤器,能对已存在的图像进行高效的处理。 |

||||

|

||||

- Core Image 是 iOS5 新加入到 iOS 平台的一个图像处理框架,提供了强大高效的图像处理功能, 用来对基于像素的图像进行操作与分析, 内置了很多强大的滤镜(Filter) (目前数量超过了180种), 这些Filter 提供了各种各样的效果, 并且还可以通过 滤镜链 将各种效果的 Filter叠加 起来形成强大的自定义效果。 |

||||

|

||||

- 一个 滤镜 是一个对象,有很多输入和输出,并执行一些变换。例如,模糊滤镜可能需要输入图像和一个模糊半径来产生适当的模糊后的输出图像。 |

||||

- 一个 滤镜链 是一个链接在一起的滤镜网络,使得一个滤镜的输出可以是另一个滤镜的输入。以这种方式,可以实现精心制作的效果。 |

||||

- iOS8 之后更是支持自定义 CIFilter,可以定制满足业务需求的复杂效果。 |

||||

|

||||

- Core Image 的优点在于十分高效。大部分情况下,它会在 GPU 中完成工作,但如果 GPU 忙,会使用 CPU 进行处理。如果设备支持 Metal,那么会使用 Metal 处理。这些操作会在底层完成,Apple 的工程师们已经帮助开发者们完成这些操作了。 |

||||

|

||||

- 例如他可以根据需求选择 CPU 或者 GPU 来处理。 |

||||

|

||||

> ```ini |

||||

> // 创建基于 CPU 的 CIContext 对象 (默认是基于 GPU,CPU 需要额外设置参数) |

||||

> context = [CIContext contextWithOptions: [NSDictionary dictionaryWithObject:[NSNumber numberWithBool:YES] forKey:kCIContextUseSoftwareRenderer]]; |

||||

> // 创建基于 GPU 的 CIContext 对象 |

||||

> context = [CIContext contextWithOptions: nil]; |

||||

> // 创建基于 GPU 的 CIContext 对象 |

||||

> EAGLContext *eaglctx = [[EAGLContext alloc] initWithAPI:kEAGLRenderingAPIOpenGLES2]; |

||||

> context = [CIContext contextWithEAGLContext:eaglctx]; |

||||

> 复制代码 |

||||

> ``` |

||||

|

||||

- Core Image 的 API 主要就是三类: |

||||

|

||||

- CIImage 保存图像数据的类,可以通过UIImage,图像文件或者像素数据来创建,包括未处理的像素数据。 |

||||

- CIFilter 表示应用的滤镜,这个框架中对图片属性进行细节处理的类。它对所有的像素进行操作,用一些键-值设置来决定具体操作的程度。 |

||||

- CIContext 表示上下文,如 Core Graphics 以及 Core Data 中的上下文用于处理绘制渲染以及处理托管对象一样,Core Image 的上下文也是实现对图像处理的具体对象。可以从其中取得图片的信息。 |

||||

|

||||

### 2.5适合视频的第三方滤镜方案 -- GPUImage |

||||

|

||||

- GPUImage |

||||

|

||||

是一个基于OpenGL ES 2.0的开源的图像处理库,优势: |

||||

|

||||

- 最低支持 iOS 4.0,iOS 5.0 之后就支持自定义滤镜。在低端机型上,GPUImage 有更好的表现。 |

||||

- GPUImage 在视频处理上有更好的表现。 |

||||

- GPUImage 的代码已经开源。可以根据自己的业务需求,定制更加复杂的管线操作。可定制程度高。 |

||||

|

||||

|

||||

原文链接:https://juejin.cn/post/6847902216238399496 |

||||

@ -0,0 +1,593 @@ |

||||

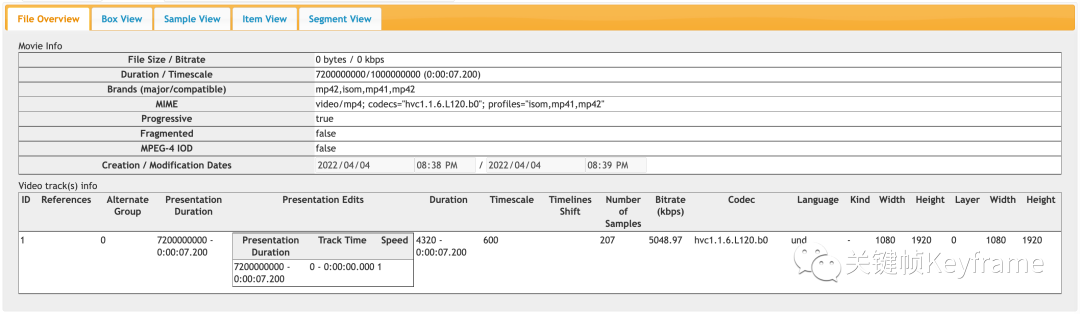

# iOS AVDemo(5):音频解码 |

||||

|

||||

iOS/Android 客户端开发同学如果想要开始学习音视频开发,最丝滑的方式是对[音视频基础概念知识](https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MjM5MTkxOTQyMQ==&action=getalbum&album_id=2140155659944787969#wechat_redirect)有一定了解后,再借助本地平台的音视频能力上手去实践音视频的`采集 → 编码 → 封装 → 解封装 → 解码 → 渲染`过程,并借助[音视频工具](https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MjM5MTkxOTQyMQ==&action=getalbum&album_id=2216997905264082945#wechat_redirect)来分析和理解对应的音视频数据。 |

||||

|

||||

在[音视频工程示例](https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MjM5MTkxOTQyMQ==&action=getalbum&album_id=2273301900659851268#wechat_redirect)这个栏目,我们将通过拆解`采集 → 编码 → 封装 → 解封装 → 解码 → 渲染`流程并实现 Demo 来向大家介绍如何在 iOS/Android 平台上手音视频开发。 |

||||

|

||||

这里是第五篇:**iOS 音频解码 Demo**。这个 Demo 里包含以下内容: |

||||

|

||||

- 1)实现一个音频解封装模块; |

||||

- 2)实现一个音频解码模块; |

||||

- 3)实现对 MP4 文件中音频部分的解封装和解码逻辑,并将解封装、解码后的数据存储为 PCM 文件; |

||||

- 4)详尽的代码注释,帮你理解代码逻辑和原理。 |

||||

|

||||

## 1、音频解封装模块 |

||||

|

||||

在这个 Demo 中,解封装模块 `KFMP4Demuxer` 的实现与 [《iOS 音频解封装 Demo》](https://mp.weixin.qq.com/s?__biz=MjM5MTkxOTQyMQ==&mid=2257484932&idx=1&sn=04fa6fb220574c0a5d417f4b527c0142&scene=21#wechat_redirect) 中一样,这里就不再重复介绍了,其接口如下: |

||||

|

||||

``` |

||||

KFMP4Demuxer.h |

||||

#import <Foundation/Foundation.h> |

||||

#import <CoreMedia/CoreMedia.h> |

||||

#import "KFDemuxerConfig.h" |

||||

|

||||

NS_ASSUME_NONNULL_BEGIN |

||||

|

||||

typedef NS_ENUM(NSInteger, KFMP4DemuxerStatus) { |

||||

KFMP4DemuxerStatusUnknown = 0, |

||||

KFMP4DemuxerStatusRunning = 1, |

||||

KFMP4DemuxerStatusFailed = 2, |

||||

KFMP4DemuxerStatusCompleted = 3, |

||||

KFMP4DemuxerStatusCancelled = 4, |

||||

}; |

||||

|

||||

@interface KFMP4Demuxer : NSObject |

||||

+ (instancetype)new NS_UNAVAILABLE; |

||||

- (instancetype)init NS_UNAVAILABLE; |

||||

- (instancetype)initWithConfig:(KFDemuxerConfig *)config; |

||||

|

||||

@property (nonatomic, strong, readonly) KFDemuxerConfig *config; |

||||

@property (nonatomic, copy) void (^errorCallBack)(NSError *error); |

||||

@property (nonatomic, assign, readonly) BOOL hasAudioTrack; // 是否包含音频数据。 |

||||

@property (nonatomic, assign, readonly) BOOL hasVideoTrack; // 是否包含视频数据。 |

||||

@property (nonatomic, assign, readonly) CGSize videoSize; // 视频大小。 |

||||

@property (nonatomic, assign, readonly) CMTime duration; // 媒体时长。 |

||||

@property (nonatomic, assign, readonly) CMVideoCodecType codecType; // 编码类型。 |

||||

@property (nonatomic, assign, readonly) KFMP4DemuxerStatus demuxerStatus; // 解封装器状态。 |

||||

@property (nonatomic, assign, readonly) BOOL audioEOF; // 是否音频结束。 |

||||

@property (nonatomic, assign, readonly) BOOL videoEOF; // 是否视频结束。 |

||||

@property (nonatomic, assign, readonly) CGAffineTransform preferredTransform; // 图像的变换信息。比如:视频图像旋转。 |

||||

|

||||

- (void)startReading:(void (^)(BOOL success, NSError *error))completeHandler; // 开始读取数据解封装。 |

||||

- (void)cancelReading; // 取消读取。 |

||||

|

||||

- (BOOL)hasAudioSampleBuffer; // 是否还有音频数据。 |

||||

- (CMSampleBufferRef)copyNextAudioSampleBuffer CF_RETURNS_RETAINED; // 拷贝下一份音频采样。 |

||||

|

||||

- (BOOL)hasVideoSampleBuffer; // 是否还有视频数据。 |

||||

- (CMSampleBufferRef)copyNextVideoSampleBuffer CF_RETURNS_RETAINED; // 拷贝下一份视频采样。 |

||||

@end |

||||

|

||||

NS_ASSUME_NONNULL_END |

||||

``` |

||||

|

||||

## 2、音频解码模块 |

||||

|

||||

接下来,我们来实现一个音频解码模块 `KFAudioDecoder`,在这里输入解封装后的编码数据,输出解码后的数据。 |

||||

|

||||

``` |

||||

KFAudioDecoder.h |

||||

#import <Foundation/Foundation.h> |

||||

#import <CoreMedia/CoreMedia.h> |

||||

|

||||

NS_ASSUME_NONNULL_BEGIN |

||||

|

||||

@interface KFAudioDecoder : NSObject |

||||

@property (nonatomic, copy) void (^sampleBufferOutputCallBack)(CMSampleBufferRef sample); // 解码器数据回调。 |

||||

@property (nonatomic, copy) void (^errorCallBack)(NSError *error); // 解码器错误回调。 |

||||

|

||||

- (void)decodeSampleBuffer:(CMSampleBufferRef)sampleBuffer; // 解码。 |

||||

@end |

||||

|

||||

NS_ASSUME_NONNULL_END |

||||

``` |

||||

|

||||

上面是 `KFAudioDecoder` 接口的设计,主要是有音频解码`数据回调`和`错误回调`的接口,另外就是`解码`的接口。 |

||||

|

||||

在上面的`解码`接口和`解码器数据回调`接口中,我们使用的是依然 **CMSampleBufferRef**[1] 作为参数或返回值类型。 |

||||

|

||||

在`解码`接口中,我们通过 `CMSampleBufferRef` 打包的是解封装后得到的 AAC 编码数据。 |

||||

|

||||

在`解码器数据回调`接口中,我们通过 `CMSampleBufferRef` 打包的是对 AAC 解码后得到的音频 PCM 数据。 |

||||

|

||||

``` |

||||

KFAudioDecoder.m |

||||

#import "KFAudioDecoder.h" |

||||

#import <AudioToolbox/AudioToolbox.h> |

||||

|

||||

// 自定义数据,用于封装音频解码回调中用到的数据。 |

||||

typedef struct KFAudioUserData { |

||||

UInt32 mChannels; |

||||

UInt32 mDataSize; |

||||

void *mData; |

||||

AudioStreamPacketDescription mPacketDesc; |

||||

} KFAudioUserData; |

||||

|

||||

@interface KFAudioDecoder () { |

||||

UInt8 *_pcmBuffer; // 解码缓冲区。 |

||||

} |

||||

@property (nonatomic, assign) AudioConverterRef audioDecoderInstance; // 音频解码器实例。 |

||||

@property (nonatomic, assign) CMFormatDescriptionRef pcmFormat; // 音频解码参数。 |

||||

@property (nonatomic, strong) dispatch_queue_t decoderQueue; |

||||

@property (nonatomic, assign) BOOL isError; |

||||

@end |

||||

|

||||

@implementation KFAudioDecoder |

||||

#pragma mark - Lifecycle |

||||

- (instancetype)init { |

||||

self = [super init]; |

||||

if (self) { |

||||

_decoderQueue = dispatch_queue_create("com.KeyFrameKit.audioDecoder", DISPATCH_QUEUE_SERIAL); |

||||

} |

||||

|

||||

return self; |

||||

} |

||||

|

||||

- (void)dealloc { |

||||

// 清理解码器。 |

||||

if (_audioDecoderInstance) { |

||||

AudioConverterDispose(_audioDecoderInstance); |

||||

_audioDecoderInstance = nil; |

||||

} |

||||

if (_pcmFormat) { |

||||

CFRelease(_pcmFormat); |

||||

_pcmFormat = NULL; |

||||

} |

||||

|

||||

// 清理缓冲区。 |

||||

if (_pcmBuffer) { |

||||

free(_pcmBuffer); |

||||

_pcmBuffer = NULL; |

||||

} |

||||

} |

||||

|

||||

#pragma mark - Public Method |

||||

- (void)decodeSampleBuffer:(CMSampleBufferRef)sampleBuffer { |

||||

if (!sampleBuffer || !CMSampleBufferGetDataBuffer(sampleBuffer) || self.isError) { |

||||

return; |

||||

} |

||||

|

||||

// 异步处理,防止主线程卡顿。 |

||||

__weak typeof(self) weakSelf = self; |

||||

CFRetain(sampleBuffer); |

||||

dispatch_async(_decoderQueue, ^{ |

||||

[weakSelf _decodeSampleBuffer:sampleBuffer]; |

||||

CFRelease(sampleBuffer); |

||||

}); |

||||

} |

||||

|

||||

#pragma mark - Private Method |

||||

- (void)_setupAudioDecoderInstanceWithInputAudioFormat:(AudioStreamBasicDescription)inputFormat error:(NSError **)error{ |

||||

if (_audioDecoderInstance != nil) { |

||||

return; |

||||

} |

||||

|

||||

// 1、设置音频解码器输出参数。其中一些参数与输入的音频数据参数一致。 |

||||

AudioStreamBasicDescription outputFormat = {0}; |

||||

outputFormat.mSampleRate = inputFormat.mSampleRate; // 输出采样率与输入一致。 |

||||

outputFormat.mFormatID = kAudioFormatLinearPCM; // 输出的 PCM 格式。 |

||||

outputFormat.mFormatFlags = kAudioFormatFlagIsSignedInteger | kAudioFormatFlagsNativeEndian | kAudioFormatFlagIsPacked; |

||||

outputFormat.mChannelsPerFrame = (UInt32) inputFormat.mChannelsPerFrame; // 输出声道数与输入一致。 |

||||

outputFormat.mFramesPerPacket = 1; // 每个包的帧数。对于 PCM 这样的非压缩音频数据,设置为 1。 |

||||

outputFormat.mBitsPerChannel = 16; // 对于 PCM,表示采样位深。 |

||||

outputFormat.mBytesPerFrame = outputFormat.mChannelsPerFrame * outputFormat.mBitsPerChannel / 8; // 每帧字节数 (byte = bit / 8)。 |

||||

outputFormat.mBytesPerPacket = outputFormat.mFramesPerPacket * outputFormat.mBytesPerFrame; // 每个包的字节数。 |

||||

outputFormat.mReserved = 0; // 对齐方式,0 表示 8 字节对齐。 |

||||

|

||||

// 2、基于音频输入和输出参数创建音频解码器。 |

||||

OSStatus status = AudioConverterNew(&inputFormat, &outputFormat, &_audioDecoderInstance); |

||||

if (status != 0) { |

||||

*error = [NSError errorWithDomain:NSStringFromClass(self.class) code:status userInfo:nil]; |

||||

} |

||||

|

||||

// 3、创建编码格式信息 _pcmFormat。 |

||||

OSStatus result = CMAudioFormatDescriptionCreate(kCFAllocatorDefault, &outputFormat, 0, NULL, 0, NULL, NULL, &_pcmFormat); |

||||

if (result != noErr) { |

||||

*error = [NSError errorWithDomain:NSStringFromClass(self.class) code:result userInfo:nil]; |

||||

return; |

||||

} |

||||

} |

||||

|

||||

- (void)_decodeSampleBuffer:(CMSampleBufferRef)sampleBuffer { |

||||

// 1、从输入数据中获取音频格式信息。 |

||||

CMAudioFormatDescriptionRef audioFormatRef = CMSampleBufferGetFormatDescription(sampleBuffer); |

||||

if (!audioFormatRef) { |

||||

return; |

||||

} |

||||

// 获取音频参数信息,AudioStreamBasicDescription 包含了音频的数据格式、声道数、采样位深、采样率等参数。 |

||||

AudioStreamBasicDescription audioFormat = *CMAudioFormatDescriptionGetStreamBasicDescription(audioFormatRef); |

||||

|

||||

// 2、根据音频参数创建解码器实例。 |

||||

NSError *error = nil; |

||||

// 第一次解码时创建解码器。 |

||||

if (!_audioDecoderInstance) { |

||||

[self _setupAudioDecoderInstanceWithInputAudioFormat:audioFormat error:&error]; |

||||

if (error) { |

||||

[self _callBackError:error]; |

||||

return; |

||||

} |

||||

if (!_audioDecoderInstance) { |

||||

return; |

||||

} |

||||

} |

||||

|

||||

// 3、获取输入数据中的 AAC 编码数据。 |

||||

CMBlockBufferRef blockBuffer = CMSampleBufferGetDataBuffer(sampleBuffer); |

||||

size_t audioLength; |

||||

char *dataPointer = NULL; |

||||

CMBlockBufferGetDataPointer(blockBuffer, 0, NULL, &audioLength, &dataPointer); |

||||

if (audioLength == 0 || !dataPointer) { |

||||

return; |

||||

} |

||||

|

||||

// 4、创建解码回调中要用到的自定义数据。 |

||||

KFAudioUserData userData = {0}; |

||||

userData.mChannels = (UInt32) audioFormat.mChannelsPerFrame; |

||||

userData.mDataSize = (UInt32) audioLength; |

||||

userData.mData = (void *) dataPointer; // 绑定 AAC 编码数据。 |

||||

userData.mPacketDesc.mDataByteSize = (UInt32) audioLength; |

||||

userData.mPacketDesc.mStartOffset = 0; |

||||

userData.mPacketDesc.mVariableFramesInPacket = 0; |

||||

|

||||

// 5、创建解码输出数据缓冲区内存空间。 |

||||

// AAC 编码的每个包有 1024 帧。 |

||||

UInt32 pcmDataPacketSize = 1024; |

||||

// 缓冲区长度:pcmDataPacketSize * 2(16 bit 采样深度) * 声道数量。 |

||||

UInt32 pcmBufferSize = (UInt32) (pcmDataPacketSize * 2 * audioFormat.mChannelsPerFrame); |

||||

if (!_pcmBuffer) { |

||||

_pcmBuffer = malloc(pcmBufferSize); |

||||

} |

||||

memset(_pcmBuffer, 0, pcmBufferSize); |

||||

|

||||

// 6、创建解码器接口对应的解码缓冲区 AudioBufferList,绑定缓冲区的内存空间。 |

||||

AudioBufferList outAudioBufferList = {0}; |

||||

outAudioBufferList.mNumberBuffers = 1; |

||||

outAudioBufferList.mBuffers[0].mNumberChannels = (UInt32) audioFormat.mChannelsPerFrame; |

||||

outAudioBufferList.mBuffers[0].mDataByteSize = (UInt32) pcmBufferSize; // 设置解码缓冲区大小。 |

||||

outAudioBufferList.mBuffers[0].mData = _pcmBuffer; // 绑定缓冲区空间。 |

||||

|

||||

// 7、输出数据描述。 |

||||

AudioStreamPacketDescription outputPacketDesc = {0}; |

||||

|

||||

// 9、解码。 |

||||

OSStatus status = AudioConverterFillComplexBuffer(self.audioDecoderInstance, inputDataProcess, &userData, &pcmDataPacketSize, &outAudioBufferList, &outputPacketDesc); |

||||

if (status != noErr) { |

||||

[self _callBackError:[NSError errorWithDomain:NSStringFromClass(self.class) code:status userInfo:nil]]; |

||||

return; |

||||

} |

||||

|

||||

if (outAudioBufferList.mBuffers[0].mDataByteSize > 0) { |

||||

// 10、获取解码后的 PCM 数据并进行封装。 |

||||

// 把解码后的 PCM 数据先封装到 CMBlockBuffer 中。 |

||||

CMBlockBufferRef pcmBlockBuffer; |

||||

size_t pcmBlockBufferSize = outAudioBufferList.mBuffers[0].mDataByteSize; |

||||

char *pcmBlockBufferDataPointer = malloc(pcmBlockBufferSize); |

||||

memcpy(pcmBlockBufferDataPointer, outAudioBufferList.mBuffers[0].mData, pcmBlockBufferSize); |

||||

OSStatus status = CMBlockBufferCreateWithMemoryBlock(kCFAllocatorDefault, |

||||

pcmBlockBufferDataPointer, |

||||

pcmBlockBufferSize, |

||||

NULL, |

||||

NULL, |

||||

0, |

||||

pcmBlockBufferSize, |

||||

0, |

||||

&pcmBlockBuffer); |

||||

if (status != noErr) { |

||||

return; |

||||

} |

||||

|

||||

// 把 PCM 数据所在的 CMBlockBuffer 封装到 CMSampleBuffer 中。 |

||||

CMSampleBufferRef pcmSampleBuffer = NULL; |

||||

CMSampleTimingInfo timingInfo = {CMTimeMake(1, audioFormat.mSampleRate), CMSampleBufferGetPresentationTimeStamp(sampleBuffer), kCMTimeInvalid }; |

||||

status = CMSampleBufferCreateReady(kCFAllocatorDefault, |

||||

pcmBlockBuffer, |

||||

_pcmFormat, |

||||

pcmDataPacketSize, |

||||

1, |

||||

&timingInfo, |

||||

0, |

||||

NULL, |

||||

&pcmSampleBuffer); |

||||

CFRelease(pcmBlockBuffer); |

||||

|

||||

// 11、回调解码数据。 |

||||

if (pcmSampleBuffer) { |

||||

if (self.sampleBufferOutputCallBack) { |

||||

self.sampleBufferOutputCallBack(pcmSampleBuffer); |

||||

} |

||||

CFRelease(pcmSampleBuffer); |

||||

} |

||||

|

||||

} |

||||

} |

||||

|

||||

- (void)_callBackError:(NSError*)error { |

||||

self.isError = YES; |

||||

if (error && self.errorCallBack) { |

||||

dispatch_async(dispatch_get_main_queue(), ^{ |

||||

self.errorCallBack(error); |

||||

}); |

||||

} |

||||

} |

||||

|

||||

#pragma mark - Decoder CallBack |

||||

static OSStatus inputDataProcess(AudioConverterRef inConverter, UInt32 *ioNumberDataPackets, AudioBufferList *ioData, AudioStreamPacketDescription **outDataPacketDescription, void *inUserData) { |

||||

KFAudioUserData *userData = (KFAudioUserData *) inUserData; |

||||

if (userData->mDataSize <= 0) { |

||||

ioNumberDataPackets = 0; |

||||

return -1; |

||||

} |

||||

|

||||

// 设置解码输出数据格式信息。 |

||||

*outDataPacketDescription = &userData->mPacketDesc; |

||||

(*outDataPacketDescription)[0].mStartOffset = 0; |

||||

(*outDataPacketDescription)[0].mDataByteSize = userData->mDataSize; |

||||

(*outDataPacketDescription)[0].mVariableFramesInPacket = 0; |

||||

|

||||

// 将待解码的数据拷贝到解码器的缓冲区的对应位置进行解码。 |

||||

ioData->mBuffers[0].mData = userData->mData; |

||||

ioData->mBuffers[0].mDataByteSize = userData->mDataSize; |

||||

ioData->mBuffers[0].mNumberChannels = userData->mChannels; |

||||

|

||||

return noErr; |

||||

} |

||||

|

||||

@end |

||||

``` |

||||

|

||||

上面是 `KFAudioDecoder` 的实现,从代码上可以看到主要有这几个部分: |

||||

|

||||

- 1)创建音频解码实例。第一次调用 `-decodeSampleBuffer:` → `-_decodeSampleBuffer:` 才会创建音频解码实例。 |

||||

|

||||

- - 在 `-_setupAudioDecoderInstanceWithInputAudioFormat:error:` 方法中实现。 |

||||

|

||||

- 2)实现音频解码逻辑,并在将数据封装到 `CMSampleBufferRef` 结构中,抛给 KFAudioDecoder 的对外数据回调接口。 |

||||

|

||||

- - 在 `-decodeSampleBuffer:` → `-_decodeSampleBuffer:` 中实现解码流程,其中涉及到待解码缓冲区、解码缓冲区的管理,并最终在 `inputDataProcess(...)` 回调中将待解码的数据拷贝到解码器的缓冲区进行解码,并设置对应的解码数据格式。 |

||||

|

||||

- 3)捕捉音频解码过程中的错误,抛给 KFAudioDecoder 的对外错误回调接口。 |

||||

|

||||

- - 在 `-_decodeSampleBuffer:` 方法中捕捉错误,在 `-_callBackError:` 方法向外回调。 |

||||

|

||||

- 4)清理音频解码器实例、解码缓冲区。 |

||||

|

||||

- - 在 `-dealloc` 方法中实现。 |

||||

|

||||

更具体细节见上述代码及其注释。 |

||||

|

||||

## 3、解封装和解码 MP4 文件中的音频部分存储为 PCM 文件 |

||||

|

||||

我们在一个 ViewController 中来实现音频解封装及解码逻辑,并将解码后的数据存储为 PCM 文件。 |

||||

|

||||

``` |

||||

#import "KFAudioDecoderViewController.h" |

||||

#import "KFMP4Demuxer.h" |

||||

#import "KFAudioDecoder.h" |

||||

|

||||

@interface KFAudioDecoderViewController () |

||||

@property (nonatomic, strong) KFDemuxerConfig *demuxerConfig; |

||||

@property (nonatomic, strong) KFMP4Demuxer *demuxer; |

||||

@property (nonatomic, strong) KFAudioDecoder *decoder; |

||||

@property (nonatomic, strong) NSFileHandle *fileHandle; |

||||

@end |

||||

|

||||

@implementation KFAudioDecoderViewController |

||||

#pragma mark - Property |

||||

- (KFDemuxerConfig *)demuxerConfig { |

||||

if (!_demuxerConfig) { |

||||

_demuxerConfig = [[KFDemuxerConfig alloc] init]; |

||||

_demuxerConfig.demuxerType = KFMediaAudio; |

||||

NSString *videoPath = [[NSBundle mainBundle] pathForResource:@"input" ofType:@"mp4"]; |

||||

_demuxerConfig.asset = [AVAsset assetWithURL:[NSURL fileURLWithPath:videoPath]]; |

||||

} |

||||

|

||||

return _demuxerConfig; |

||||

} |

||||

|

||||

- (KFMP4Demuxer *)demuxer { |

||||

if (!_demuxer) { |

||||

_demuxer = [[KFMP4Demuxer alloc] initWithConfig:self.demuxerConfig]; |

||||

_demuxer.errorCallBack = ^(NSError *error) { |

||||

NSLog(@"KFMP4Demuxer error:%zi %@", error.code, error.localizedDescription); |

||||

}; |

||||

} |

||||

|

||||

return _demuxer; |

||||

} |

||||

|

||||

- (KFAudioDecoder *)decoder { |

||||

if (!_decoder) { |

||||

__weak typeof(self) weakSelf = self; |

||||

_decoder = [[KFAudioDecoder alloc] init]; |

||||

_decoder.errorCallBack = ^(NSError *error) { |

||||

NSLog(@"KFAudioDecoder error:%zi %@", error.code, error.localizedDescription); |

||||

}; |

||||

// 解码数据回调。在这里把解码后的音频 PCM 数据存储为文件。 |

||||

_decoder.sampleBufferOutputCallBack = ^(CMSampleBufferRef sampleBuffer) { |

||||

if (sampleBuffer) { |

||||

CMBlockBufferRef blockBuffer = CMSampleBufferGetDataBuffer(sampleBuffer); |

||||

size_t totolLength; |

||||

char *dataPointer = NULL; |

||||

CMBlockBufferGetDataPointer(blockBuffer, 0, NULL, &totolLength, &dataPointer); |

||||

if (totolLength == 0 || !dataPointer) { |

||||

return; |

||||

} |

||||

|

||||

[weakSelf.fileHandle writeData:[NSData dataWithBytes:dataPointer length:totolLength]]; |

||||

} |

||||

}; |

||||

} |

||||

|

||||

return _decoder; |

||||

} |

||||

|

||||

- (NSFileHandle *)fileHandle { |

||||

if (!_fileHandle) { |

||||

NSString *videoPath = [[NSSearchPathForDirectoriesInDomains(NSDocumentDirectory, NSUserDomainMask, YES) lastObject] stringByAppendingPathComponent:@"output.pcm"]; |

||||

[[NSFileManager defaultManager] removeItemAtPath:videoPath error:nil]; |

||||

[[NSFileManager defaultManager] createFileAtPath:videoPath contents:nil attributes:nil]; |

||||

_fileHandle = [NSFileHandle fileHandleForWritingAtPath:videoPath]; |

||||

} |

||||

|

||||

return _fileHandle; |

||||

} |

||||

|

||||

#pragma mark - Lifecycle |

||||

- (void)viewDidLoad { |

||||

[super viewDidLoad]; |

||||

|

||||

[self setupUI]; |

||||

|

||||

// 完成音频解码后,可以将 App Document 文件夹下面的 output.pcm 文件拷贝到电脑上,使用 ffplay 播放: |

||||

// ffplay -ar 44100 -channels 1 -f s16le -i output.pcm |

||||

} |

||||

|

||||

- (void)dealloc { |

||||

if (_fileHandle) { |

||||

[_fileHandle closeFile]; |

||||

_fileHandle = nil; |

||||

} |

||||

} |

||||

|

||||

#pragma mark - Setup |

||||

- (void)setupUI { |

||||

self.edgesForExtendedLayout = UIRectEdgeAll; |

||||

self.extendedLayoutIncludesOpaqueBars = YES; |

||||

self.title = @"Audio Decoder"; |

||||

self.view.backgroundColor = [UIColor whiteColor]; |

||||

|

||||

// Navigation item. |

||||

UIBarButtonItem *startBarButton = [[UIBarButtonItem alloc] initWithTitle:@"Start" style:UIBarButtonItemStylePlain target:self action:@selector(start)]; |

||||

self.navigationItem.rightBarButtonItems = @[startBarButton]; |

||||

} |

||||

|

||||

#pragma mark - Action |

||||

- (void)start { |

||||

__weak typeof(self) weakSelf = self; |

||||

NSLog(@"KFMP4Demuxer start"); |

||||

[self.demuxer startReading:^(BOOL success, NSError * _Nonnull error) { |

||||

if (success) { |

||||

// Demuxer 启动成功后,就可以从它里面获取解封装后的数据了。 |

||||

[weakSelf fetchAndDecodeDemuxedData]; |

||||

} else { |

||||

NSLog(@"KFMP4Demuxer error:%zi %@", error.code, error.localizedDescription); |

||||

} |

||||

}]; |

||||

} |

||||

|

||||

#pragma mark - Utility |

||||

- (void)fetchAndDecodeDemuxedData { |

||||

// 异步地从 Demuxer 获取解封装后的 AAC 编码数据,送给解码器进行解码。 |

||||

__weak typeof(self) weakSelf = self; |

||||

dispatch_async(dispatch_get_global_queue(0, 0), ^{ |

||||

while (weakSelf.demuxer.hasAudioSampleBuffer) { |

||||

CMSampleBufferRef audioBuffer = [weakSelf.demuxer copyNextAudioSampleBuffer]; |

||||

if (audioBuffer) { |

||||

[weakSelf decodeSampleBuffer:audioBuffer]; |

||||

CFRelease(audioBuffer); |

||||

} |

||||

} |

||||

if (weakSelf.demuxer.demuxerStatus == KFMP4DemuxerStatusCompleted) { |

||||

NSLog(@"KFMP4Demuxer complete"); |

||||

} |

||||

}); |

||||

} |

||||

|

||||

- (void)decodeSampleBuffer:(CMSampleBufferRef)sampleBuffer { |

||||

// 获取解封装后的 AAC 编码裸数据。 |

||||

CMBlockBufferRef blockBuffer = CMSampleBufferGetDataBuffer(sampleBuffer); |

||||

size_t totolLength; |

||||

char *dataPointer = NULL; |

||||

CMBlockBufferGetDataPointer(blockBuffer, 0, NULL, &totolLength, &dataPointer); |

||||

if (totolLength == 0 || !dataPointer) { |

||||

return; |

||||

} |

||||

|

||||

// 目前 AudioDecoder 的解码接口实现的是单包(packet,1 packet 有 1024 帧)解码。而从 Demuxer 获取的一个 CMSampleBuffer 可能包含多个包,所以这里要拆一下包,再送给解码器。 |

||||

NSLog(@"SampleNum: %ld", CMSampleBufferGetNumSamples(sampleBuffer)); |

||||

for (NSInteger index = 0; index < CMSampleBufferGetNumSamples(sampleBuffer); index++) { |

||||

// 1、获取一个包的数据。 |

||||

size_t sampleSize = CMSampleBufferGetSampleSize(sampleBuffer, index); |

||||

CMSampleTimingInfo timingInfo; |

||||

CMSampleBufferGetSampleTimingInfo(sampleBuffer, index, &timingInfo); |

||||

char *sampleDataPointer = malloc(sampleSize); |

||||

memcpy(sampleDataPointer, dataPointer, sampleSize); |

||||

|

||||

// 2、将数据封装到 CMBlockBuffer 中。 |

||||

CMBlockBufferRef packetBlockBuffer; |

||||

OSStatus status = CMBlockBufferCreateWithMemoryBlock(kCFAllocatorDefault, |

||||

sampleDataPointer, |

||||

sampleSize, |

||||

NULL, |

||||

NULL, |

||||

0, |

||||

sampleSize, |

||||

0, |

||||

&packetBlockBuffer); |

||||

|

||||

if (status == noErr) { |

||||

// 3、将 CMBlockBuffer 封装到 CMSampleBuffer 中。 |

||||

CMSampleBufferRef frameSampleBuffer = NULL; |

||||

const size_t sampleSizeArray[] = {sampleSize}; |

||||

status = CMSampleBufferCreateReady(kCFAllocatorDefault, |

||||

packetBlockBuffer, |

||||

CMSampleBufferGetFormatDescription(sampleBuffer), |

||||

1, |

||||

1, |

||||

&timingInfo, |

||||

1, |

||||

sampleSizeArray, |

||||

&frameSampleBuffer); |

||||

CFRelease(packetBlockBuffer); |

||||

|

||||

// 4、解码这个包的数据。 |

||||

if (frameSampleBuffer) { |

||||

[self.decoder decodeSampleBuffer:frameSampleBuffer]; |

||||

CFRelease(frameSampleBuffer); |

||||

} |

||||

} |

||||

dataPointer += sampleSize; |

||||

} |

||||

} |

||||

|

||||

@end |

||||

``` |

||||

|

||||

上面是 `KFAudioDecoderViewController` 的实现,其中主要包含这几个部分: |

||||

|

||||

- 1)通过启动音频解封装来驱动整个解封装和解码流程。 |

||||

|

||||

- - 在 `-start` 中实现开始动作。 |

||||

|

||||

- 2)在解封装模块 `KFMP4Demuxer` 启动成功后,开始读取解封装数据并启动解码。 |

||||

|

||||

- - 在 `-fetchAndDecodeDemuxedData` 方法中实现。 |

||||

|

||||

- 3)将解封装后的数据拆包,以包为单位封装为 `CMSampleBuffer` 送给解码器解码。 |

||||

|

||||

- - 在 `-decodeSampleBuffer:` 方法中实现。 |

||||

|

||||

- 4)在解码模块 `KFAudioDecoder` 的数据回调中获取解码后的 PCM 数据存储为文件。 |

||||

|

||||

- - 在 `KFAudioDecoder` 的 `sampleBufferOutputCallBack` 回调中实现。 |

||||

|

||||

## 4、用工具播放 PCM 文件 |

||||

|

||||

完成音频解码后,可以将 App Document 文件夹下面的 `output.pcm` 文件拷贝到电脑上,使用 `ffplay` 播放来验证一下音频采集是效果是否符合预期: |

||||

|

||||

``` |

||||

$ ffplay -ar 44100 -channels 1 -f s16le -i output.pcm |

||||

``` |

||||

|

||||

注意这里的参数要对齐在工程中输入视频源的`采样率`、`声道数`、`采样位深`。比如我们的 Demo 中输入视频源的声道数是 1,所以上面的声道数需要设置为 1 才能播放正常的声音。 |

||||

|

||||

关于播放 PCM 文件的工具,可以参考[《FFmpeg 工具》第 2 节 ffplay 命令行工具](https://mp.weixin.qq.com/s?__biz=MjM5MTkxOTQyMQ==&mid=2257484831&idx=1&sn=6bab905a5040c46b971bab05f787788b&scene=21#wechat_redirect)和[《可视化音视频分析工具》第 1.1 节 Adobe Audition](https://mp.weixin.qq.com/s?__biz=MjM5MTkxOTQyMQ==&mid=2257484834&idx=1&sn=5dd9768bfc0d01ca1b036be8dd2f5fa1&scene=21#wechat_redirect)。 |

||||

|

||||

## 5、参考资料 |

||||

|

||||

[1]CMSampleBufferRef: *https://developer.apple.com/documentation/coremedia/cmsamplebufferref/* |

||||

|

||||

|

||||

|

||||

原文链接:https://mp.weixin.qq.com/s/7Db81B9i16cLuq0jS42bmg |

||||

|

||||

@ -0,0 +1,576 @@ |

||||

# iOS AVDemo(6):音频渲染 |

||||

|

||||

iOS/Android 客户端开发同学如果想要开始学习音视频开发,最丝滑的方式是对[音视频基础概念知识](https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MjM5MTkxOTQyMQ==&action=getalbum&album_id=2140155659944787969#wechat_redirect)有一定了解后,再借助 iOS/Android 平台的音视频能力上手去实践音视频的`采集 → 编码 → 封装 → 解封装 → 解码 → 渲染`过程,并借助[音视频工具](https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MjM5MTkxOTQyMQ==&action=getalbum&album_id=2216997905264082945#wechat_redirect)来分析和理解对应的音视频数据。 |

||||

|

||||

在[音视频工程示例](https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MjM5MTkxOTQyMQ==&action=getalbum&album_id=2273301900659851268#wechat_redirect)这个栏目,我们将通过拆解`采集 → 编码 → 封装 → 解封装 → 解码 → 渲染`流程并实现 Demo 来向大家介绍如何在 iOS/Android 平台上手音视频开发。 |

||||

|

||||

这里是第六篇:**iOS 音频渲染 Demo**。这个 Demo 里包含以下内容: |

||||

|

||||

- 1)实现一个音频解封装模块; |

||||

- 2)实现一个音频解码模块; |

||||

- 3)实现一个音频渲染模块; |

||||

- 4)实现对 MP4 文件中音频部分的解封装和解码逻辑,并将解封装、解码后的数据送给渲染模块播放; |

||||

- 5)详尽的代码注释,帮你理解代码逻辑和原理。 |

||||

|

||||

## 1、音频解封装模块 |

||||

|

||||

在这个 Demo 中,解封装模块 `KFMP4Demuxer` 的实现与 [《iOS 音频解封装 Demo》](https://mp.weixin.qq.com/s?__biz=MjM5MTkxOTQyMQ==&mid=2257484932&idx=1&sn=04fa6fb220574c0a5d417f4b527c0142&scene=21#wechat_redirect) 中一样,这里就不再重复介绍了,其接口如下: |

||||

|

||||

``` |

||||

KFMP4Demuxer.h |

||||

#import <Foundation/Foundation.h> |

||||

#import <CoreMedia/CoreMedia.h> |

||||

#import "KFDemuxerConfig.h" |

||||

|

||||

NS_ASSUME_NONNULL_BEGIN |

||||

|

||||

typedef NS_ENUM(NSInteger, KFMP4DemuxerStatus) { |

||||

KFMP4DemuxerStatusUnknown = 0, |

||||

KFMP4DemuxerStatusRunning = 1, |

||||

KFMP4DemuxerStatusFailed = 2, |

||||

KFMP4DemuxerStatusCompleted = 3, |

||||

KFMP4DemuxerStatusCancelled = 4, |

||||

}; |

||||

|

||||

@interface KFMP4Demuxer : NSObject |

||||

+ (instancetype)new NS_UNAVAILABLE; |

||||

- (instancetype)init NS_UNAVAILABLE; |

||||

- (instancetype)initWithConfig:(KFDemuxerConfig *)config; |

||||

|

||||

@property (nonatomic, strong, readonly) KFDemuxerConfig *config; |

||||

@property (nonatomic, copy) void (^errorCallBack)(NSError *error); |

||||

@property (nonatomic, assign, readonly) BOOL hasAudioTrack; // 是否包含音频数据。 |

||||

@property (nonatomic, assign, readonly) BOOL hasVideoTrack; // 是否包含视频数据。 |

||||

@property (nonatomic, assign, readonly) CGSize videoSize; // 视频大小。 |

||||

@property (nonatomic, assign, readonly) CMTime duration; // 媒体时长。 |

||||

@property (nonatomic, assign, readonly) CMVideoCodecType codecType; // 编码类型。 |

||||

@property (nonatomic, assign, readonly) KFMP4DemuxerStatus demuxerStatus; // 解封装器状态。 |

||||

@property (nonatomic, assign, readonly) BOOL audioEOF; // 是否音频结束。 |

||||

@property (nonatomic, assign, readonly) BOOL videoEOF; // 是否视频结束。 |

||||

@property (nonatomic, assign, readonly) CGAffineTransform preferredTransform; // 图像的变换信息。比如:视频图像旋转。 |

||||

|

||||

- (void)startReading:(void (^)(BOOL success, NSError *error))completeHandler; // 开始读取数据解封装。 |

||||

- (void)cancelReading; // 取消读取。 |

||||

|

||||

- (BOOL)hasAudioSampleBuffer; // 是否还有音频数据。 |

||||

- (CMSampleBufferRef)copyNextAudioSampleBuffer CF_RETURNS_RETAINED; // 拷贝下一份音频采样。 |

||||

|

||||

- (BOOL)hasVideoSampleBuffer; // 是否还有视频数据。 |

||||

- (CMSampleBufferRef)copyNextVideoSampleBuffer CF_RETURNS_RETAINED; // 拷贝下一份视频采样。 |

||||

@end |

||||

|

||||

NS_ASSUME_NONNULL_END |

||||

``` |

||||

|

||||

## 2、音频解码模块 |

||||

|

||||

同样的,解封装模块 `KFAudioDecoder` 的实现与 [《iOS 音频解码 Demo》](https://mp.weixin.qq.com/s?__biz=MjM5MTkxOTQyMQ==&mid=2257484944&idx=1&sn=63616655888d93557f935bc12088873e&scene=21#wechat_redirect) 中一样,这里就不再重复介绍了,其接口如下: |

||||

|

||||

``` |

||||

KFAudioDecoder.h |

||||

#import <Foundation/Foundation.h> |

||||

#import <CoreMedia/CoreMedia.h> |

||||

|

||||

NS_ASSUME_NONNULL_BEGIN |

||||

|

||||

@interface KFAudioDecoder : NSObject |

||||

@property (nonatomic, copy) void (^sampleBufferOutputCallBack)(CMSampleBufferRef sample); // 解码器数据回调。 |

||||

@property (nonatomic, copy) void (^errorCallBack)(NSError *error); // 解码器错误回调。 |

||||

|

||||

- (void)decodeSampleBuffer:(CMSampleBufferRef)sampleBuffer; // 解码。 |

||||

@end |

||||

|

||||

NS_ASSUME_NONNULL_END |

||||

``` |

||||

|

||||

## 3、音频渲染模块 |

||||

|

||||

接下来,我们来实现一个音频渲染模块 `KFAudioRender`,在这里输入解码后的数据进行渲染播放。 |

||||

|

||||

``` |

||||

KFAudioRender.h |

||||

#import <Foundation/Foundation.h> |

||||

#import <AVFoundation/AVFoundation.h> |

||||

|

||||

@class KFAudioRender; |

||||

|

||||

NS_ASSUME_NONNULL_BEGIN |

||||

|

||||

@interface KFAudioRender : NSObject |

||||

+ (instancetype)new NS_UNAVAILABLE; |

||||

- (instancetype)init NS_UNAVAILABLE; |

||||

- (instancetype)initWithChannels:(NSInteger)channels bitDepth:(NSInteger)bitDepth sampleRate:(NSInteger)sampleRate; |

||||

|

||||

@property (nonatomic, copy) void (^audioBufferInputCallBack)(AudioBufferList *audioBufferList); // 音频渲染数据输入回调。 |

||||

@property (nonatomic, copy) void (^errorCallBack)(NSError *error); // 音频渲染错误回调。 |

||||

@property (nonatomic, assign, readonly) NSInteger audioChannels; // 声道数。 |

||||

@property (nonatomic, assign, readonly) NSInteger bitDepth; // 采样位深。 |

||||

@property (nonatomic, assign, readonly) NSInteger audioSampleRate; // 采样率。 |

||||

|

||||

- (void)startPlaying; // 开始渲染。 |

||||

- (void)stopPlaying; // 结束渲染。 |

||||

@end |

||||

|

||||

NS_ASSUME_NONNULL_END |

||||

``` |

||||

|

||||

上面是 `KFAudioRender` 接口的设计,除了`初始化`接口,主要是有音频渲染`数据输入回调`和`错误回调`的接口,另外就是`获取声道数`和`获取采样率`的接口,以及`开始渲染`和`结束渲染`的接口。 |

||||

|

||||

这里重点需要看一下音频渲染`数据输入回调`接口,系统的音频渲染单元每次会主动通过回调的方式要数据,我们这里封装的 `KFAudioRender` 则是用`数据输入回调`接口来从外部获取一组待渲染的音频数据送给系统的音频渲染单元。 |

||||

|

||||

``` |

||||

KFAudioRender.m |

||||

#import "KFAudioRender.h" |

||||

|

||||

#define OutputBus 0 |

||||

|

||||

@interface KFAudioRender () |

||||

@property (nonatomic, assign) AudioComponentInstance audioRenderInstance; // 音频渲染实例。 |

||||

@property (nonatomic, assign, readwrite) NSInteger audioChannels; // 声道数。 |

||||

@property (nonatomic, assign, readwrite) NSInteger bitDepth; // 采样位深。 |

||||

@property (nonatomic, assign, readwrite) NSInteger audioSampleRate; // 采样率。 |

||||

@property (nonatomic, strong) dispatch_queue_t renderQueue; |

||||

@property (nonatomic, assign) BOOL isError; |

||||

@end |

||||

|

||||

@implementation KFAudioRender |

||||

#pragma mark - Lifecycle |

||||

- (instancetype)initWithChannels:(NSInteger)channels bitDepth:(NSInteger)bitDepth sampleRate:(NSInteger)sampleRate { |

||||

self = [super init]; |

||||

if (self) { |

||||

_audioChannels = channels; |

||||

_bitDepth = bitDepth; |

||||

_audioSampleRate = sampleRate; |

||||

_renderQueue = dispatch_queue_create("com.KeyFrameKit.audioRender", DISPATCH_QUEUE_SERIAL); |

||||

} |

||||

|

||||

return self; |

||||

} |

||||

|

||||

- (void)dealloc { |

||||

// 清理音频渲染实例。 |

||||

if (_audioRenderInstance) { |

||||

AudioOutputUnitStop(_audioRenderInstance); |

||||

AudioUnitUninitialize(_audioRenderInstance); |

||||

AudioComponentInstanceDispose(_audioRenderInstance); |

||||

_audioRenderInstance = nil; |

||||

} |

||||

} |

||||

|

||||

#pragma mark - Action |

||||

- (void)startPlaying { |

||||

__weak typeof(self) weakSelf = self; |

||||

dispatch_async(_renderQueue, ^{ |

||||

if (!weakSelf.audioRenderInstance) { |

||||

NSError *error = nil; |

||||

// 第一次 startPlaying 时创建音频渲染实例。 |

||||

[weakSelf _setupAudioRenderInstance:&error]; |

||||

if (error) { |

||||

// 捕捉并回调创建音频渲染实例时的错误。 |

||||

[weakSelf _callBackError:error]; |

||||

return; |

||||

} |

||||

} |

||||

|

||||

// 开始渲染。 |

||||

OSStatus status = AudioOutputUnitStart(weakSelf.audioRenderInstance); |

||||

if (status != noErr) { |

||||

// 捕捉并回调开始渲染时的错误。 |

||||

[weakSelf _callBackError:[NSError errorWithDomain:NSStringFromClass([KFAudioRender class]) code:status userInfo:nil]]; |

||||

} |

||||

}); |

||||

} |

||||

|

||||

- (void)stopPlaying { |

||||

__weak typeof(self) weakSelf = self; |

||||

dispatch_async(_renderQueue, ^{ |

||||

if (weakSelf.audioRenderInstance && !self.isError) { |

||||

// 停止渲染。 |

||||

OSStatus status = AudioOutputUnitStop(weakSelf.audioRenderInstance); |

||||

// 捕捉并回调停止渲染时的错误。 |

||||

if (status != noErr) { |

||||

[weakSelf _callBackError:[NSError errorWithDomain:NSStringFromClass([KFAudioRender class]) code:status userInfo:nil]]; |

||||

} |

||||

} |

||||

}); |

||||

} |

||||

|

||||

#pragma mark - Private Method |

||||

- (void)_setupAudioRenderInstance:(NSError**)error { |

||||

// 1、设置音频组件描述。 |

||||

AudioComponentDescription audioComponentDescription = { |

||||

.componentType = kAudioUnitType_Output, |

||||

//.componentSubType = kAudioUnitSubType_VoiceProcessingIO, // 回声消除模式 |

||||

.componentSubType = kAudioUnitSubType_RemoteIO, |

||||

.componentManufacturer = kAudioUnitManufacturer_Apple, |

||||

.componentFlags = 0, |

||||

.componentFlagsMask = 0 |

||||

}; |

||||

|

||||

// 2、查找符合指定描述的音频组件。 |

||||

AudioComponent inputComponent = AudioComponentFindNext(NULL, &audioComponentDescription); |

||||

|

||||

// 3、创建音频组件实例。 |

||||

OSStatus status = AudioComponentInstanceNew(inputComponent, &_audioRenderInstance); |

||||

if (status != noErr) { |

||||

*error = [NSError errorWithDomain:NSStringFromClass(self.class) code:status userInfo:nil]; |

||||

return; |

||||

} |

||||

|

||||

// 4、设置实例的属性:可读写。0 不可读写,1 可读写。 |

||||

UInt32 flag = 1; |

||||

status = AudioUnitSetProperty(_audioRenderInstance, kAudioOutputUnitProperty_EnableIO, kAudioUnitScope_Output, OutputBus, &flag, sizeof(flag)); |

||||

if (status != noErr) { |

||||

*error = [NSError errorWithDomain:NSStringFromClass(self.class) code:status userInfo:nil]; |

||||

return; |

||||

} |

||||

|

||||

// 5、设置实例的属性:音频参数,如:数据格式、声道数、采样位深、采样率等。 |

||||

AudioStreamBasicDescription inputFormat = {0}; |

||||

inputFormat.mFormatID = kAudioFormatLinearPCM; // 原始数据为 PCM,采用声道交错格式。 |

||||

inputFormat.mFormatFlags = kAudioFormatFlagIsSignedInteger | kAudioFormatFlagsNativeEndian | kAudioFormatFlagIsPacked; |

||||

inputFormat.mChannelsPerFrame = (UInt32) self.audioChannels; // 每帧的声道数。 |

||||

inputFormat.mFramesPerPacket = 1; // 每个数据包帧数。 |

||||

inputFormat.mBitsPerChannel = (UInt32) self.bitDepth; // 采样位深。 |

||||

inputFormat.mBytesPerFrame = inputFormat.mChannelsPerFrame * inputFormat.mBitsPerChannel / 8; // 每帧字节数 (byte = bit / 8)。 |

||||

inputFormat.mBytesPerPacket = inputFormat.mFramesPerPacket * inputFormat.mBytesPerFrame; // 每个包字节数。 |

||||

inputFormat.mSampleRate = self.audioSampleRate; // 采样率 |

||||

status = AudioUnitSetProperty(_audioRenderInstance, kAudioUnitProperty_StreamFormat, kAudioUnitScope_Input, OutputBus, &inputFormat, sizeof(inputFormat)); |

||||

if (status != noErr) { |

||||

*error = [NSError errorWithDomain:NSStringFromClass(self.class) code:status userInfo:nil]; |

||||

return; |

||||

} |

||||

|

||||

// 6、设置实例的属性:数据回调函数。 |

||||

AURenderCallbackStruct renderCallbackRef = { |

||||

.inputProc = audioRenderCallback, |

||||

.inputProcRefCon = (__bridge void *) (self) // 对应回调函数中的 *inRefCon。 |

||||

}; |

||||

status = AudioUnitSetProperty(_audioRenderInstance, kAudioUnitProperty_SetRenderCallback, kAudioUnitScope_Global, OutputBus, &renderCallbackRef, sizeof(renderCallbackRef)); |

||||

if (status != noErr) { |

||||

*error = [NSError errorWithDomain:NSStringFromClass(self.class) code:status userInfo:nil]; |

||||

return; |

||||

} |

||||

|

||||

// 7、初始化实例。 |

||||

status = AudioUnitInitialize(_audioRenderInstance); |

||||

if (status != noErr) { |

||||

*error = [NSError errorWithDomain:NSStringFromClass(self.class) code:status userInfo:nil]; |

||||

return; |

||||

} |

||||

} |

||||

|

||||

- (void)_callBackError:(NSError*)error { |

||||

self.isError = YES; |

||||

if (self.errorCallBack) { |

||||

dispatch_async(dispatch_get_main_queue(), ^{ |

||||

self.errorCallBack(error); |

||||

}); |

||||

} |

||||

} |

||||

|

||||

#pragma mark - Render Callback |

||||

static OSStatus audioRenderCallback(void *inRefCon, AudioUnitRenderActionFlags *ioActionFlags, const AudioTimeStamp *inTimeStamp, UInt32 inOutputBusNumber, UInt32 inNumberFrames, AudioBufferList *ioData) { |

||||

// 通过音频渲染数据输入回调从外部获取待渲染的数据。 |

||||

KFAudioRender *audioRender = (__bridge KFAudioRender *) inRefCon; |

||||

if (audioRender.audioBufferInputCallBack) { |

||||

audioRender.audioBufferInputCallBack(ioData); |

||||

} |

||||

|

||||

return noErr; |

||||

} |

||||

|

||||

@end |

||||

``` |

||||

|

||||

上面是 `KFAudioRender` 的实现,从代码上可以看到主要有这几个部分: |

||||

|

||||

- 1)创建音频渲染实例。第一次调用 `-startPlaying` 才会创建音频渲染实例。 |

||||

|

||||

- - 在 `-_setupAudioRenderInstance:` 方法中实现。 |

||||

|

||||

- 2)处理音频渲染实例的数据回调,并在回调中通过 KFAudioRender 的对外数据输入回调接口向更外层要待渲染的数据。 |

||||

|

||||

- - 在 `audioRenderCallback(...)` 方法中实现回调处理逻辑。通过 `audioBufferInputCallBack` 回调接口向更外层要数据。 |

||||

|

||||

- 3)实现开始渲染和停止渲染逻辑。 |

||||

|

||||

- - 分别在 `-startPlaying` 和 `-stopPlaying` 方法中实现。注意,这里是开始和停止操作都是放在串行队列中通过 `dispatch_async` 异步处理的,这里主要是为了防止主线程卡顿。 |

||||

|

||||

- 4)捕捉音频渲染开始和停止操作中的错误,抛给 KFAudioRender 的对外错误回调接口。 |

||||

|

||||

- - 在 `-startPlaying` 和 `-stopPlaying` 方法中捕捉错误,在 `-_callBackError:` 方法向外回调。 |

||||

|

||||

- 5)清理音频渲染实例。 |

||||

|

||||

- - 在 `-dealloc` 方法中实现。 |

||||

|

||||

更具体细节见上述代码及其注释。 |

||||

|

||||

## 4、解封装和解码 MP4 文件中的音频部分并渲染播放 |

||||

|

||||

我们在一个 ViewController 中来实现从 MP4 文件中解封装和解码音频数据进行渲染播放。 |

||||

|

||||

``` |

||||

KFAudioRenderViewController.m |

||||

#import "KFAudioRenderViewController.h" |

||||

#import <AVFoundation/AVFoundation.h> |

||||

#import "KFAudioRender.h" |

||||

#import "KFMP4Demuxer.h" |

||||

#import "KFAudioDecoder.h" |

||||

#import "KFWeakProxy.h" |

||||

|

||||

#define KFDecoderMaxCache 4096 * 5 // 解码数据缓冲区最大长度。 |

||||

|

||||

@interface KFAudioRenderViewController () |

||||

@property (nonatomic, strong) KFDemuxerConfig *demuxerConfig; |

||||

@property (nonatomic, strong) KFMP4Demuxer *demuxer; |

||||

@property (nonatomic, strong) KFAudioDecoder *decoder; |

||||

@property (nonatomic, strong) KFAudioRender *audioRender; |

||||

@property (nonatomic, strong) dispatch_semaphore_t semaphore; |

||||

@property (nonatomic, strong) NSMutableData *pcmDataCache; // 解码数据缓冲区。 |

||||

@property (nonatomic, assign) NSInteger pcmDataCacheLength; |

||||

@property (nonatomic, strong) CADisplayLink *timer; |

||||

@end |

||||

|

||||

@implementation KFAudioRenderViewController |

||||

#pragma mark - Property |

||||

- (KFDemuxerConfig *)demuxerConfig { |

||||

if (!_demuxerConfig) { |

||||

_demuxerConfig = [[KFDemuxerConfig alloc] init]; |

||||

_demuxerConfig.demuxerType = KFMediaAudio; |

||||

NSString *videoPath = [[NSBundle mainBundle] pathForResource:@"input" ofType:@"mp4"]; |

||||

_demuxerConfig.asset = [AVAsset assetWithURL:[NSURL fileURLWithPath:videoPath]]; |

||||

} |

||||

|

||||

return _demuxerConfig; |

||||

} |

||||

|

||||

- (KFMP4Demuxer *)demuxer { |

||||

if (!_demuxer) { |

||||

_demuxer = [[KFMP4Demuxer alloc] initWithConfig:self.demuxerConfig]; |

||||

_demuxer.errorCallBack = ^(NSError *error) { |

||||

NSLog(@"KFMP4Demuxer error:%zi %@", error.code, error.localizedDescription); |

||||

}; |

||||

} |

||||

|

||||

return _demuxer; |

||||

} |

||||

|

||||

- (KFAudioDecoder *)decoder { |

||||

if (!_decoder) { |

||||

__weak typeof(self) weakSelf = self; |

||||

_decoder = [[KFAudioDecoder alloc] init]; |

||||

_decoder.errorCallBack = ^(NSError *error) { |

||||

NSLog(@"KFAudioDecoder error:%zi %@", error.code, error.localizedDescription); |

||||

}; |

||||

// 解码数据回调。在这里把解码后的音频 PCM 数据缓冲起来等待渲染。 |

||||

_decoder.sampleBufferOutputCallBack = ^(CMSampleBufferRef sampleBuffer) { |

||||

if (sampleBuffer) { |

||||

CMBlockBufferRef blockBuffer = CMSampleBufferGetDataBuffer(sampleBuffer); |

||||

size_t totolLength; |

||||

char *dataPointer = NULL; |

||||

CMBlockBufferGetDataPointer(blockBuffer, 0, NULL, &totolLength, &dataPointer); |

||||

if (totolLength == 0 || !dataPointer) { |

||||

return; |

||||

} |

||||

dispatch_semaphore_wait(weakSelf.semaphore, DISPATCH_TIME_FOREVER); |

||||

[weakSelf.pcmDataCache appendData:[NSData dataWithBytes:dataPointer length:totolLength]]; |

||||

weakSelf.pcmDataCacheLength += totolLength; |

||||

dispatch_semaphore_signal(weakSelf.semaphore); |

||||

} |

||||

}; |

||||

} |

||||

|

||||

return _decoder; |

||||

} |

||||

|

||||

- (KFAudioRender *)audioRender { |

||||

if (!_audioRender) { |

||||

__weak typeof(self) weakSelf = self; |

||||

// 这里设置的音频声道数、采样位深、采样率需要跟输入源的音频参数一致。 |

||||

_audioRender = [[KFAudioRender alloc] initWithChannels:1 bitDepth:16 sampleRate:44100]; |

||||

_audioRender.errorCallBack = ^(NSError* error) { |

||||

NSLog(@"KFAudioRender error:%zi %@", error.code, error.localizedDescription); |

||||

}; |

||||

// 渲染输入数据回调。在这里把缓冲区的数据交给系统音频渲染单元渲染。 |

||||

_audioRender.audioBufferInputCallBack = ^(AudioBufferList * _Nonnull audioBufferList) { |

||||

if (weakSelf.pcmDataCacheLength < audioBufferList->mBuffers[0].mDataByteSize) { |

||||

memset(audioBufferList->mBuffers[0].mData, 0, audioBufferList->mBuffers[0].mDataByteSize); |

||||

} else { |

||||

dispatch_semaphore_wait(weakSelf.semaphore, DISPATCH_TIME_FOREVER); |

||||

memcpy(audioBufferList->mBuffers[0].mData, weakSelf.pcmDataCache.bytes, audioBufferList->mBuffers[0].mDataByteSize); |

||||

[weakSelf.pcmDataCache replaceBytesInRange:NSMakeRange(0, audioBufferList->mBuffers[0].mDataByteSize) withBytes:NULL length:0]; |

||||

weakSelf.pcmDataCacheLength -= audioBufferList->mBuffers[0].mDataByteSize; |

||||

dispatch_semaphore_signal(weakSelf.semaphore); |

||||

} |

||||

}; |

||||

} |

||||

|

||||

return _audioRender; |

||||

} |

||||

|

||||

#pragma mark - Lifecycle |

||||

- (void)viewDidLoad { |

||||

[super viewDidLoad]; |

||||

|

||||

_semaphore = dispatch_semaphore_create(1); |

||||

_pcmDataCache = [[NSMutableData alloc] init]; |

||||

|

||||

[self setupAudioSession]; |

||||

[self setupUI]; |

||||

|

||||

// 通过一个 timer 来保证持续从文件中解封装和解码一定量的数据。 |

||||

_timer = [CADisplayLink displayLinkWithTarget:[KFWeakProxy proxyWithTarget:self] selector:@selector(timerCallBack:)]; |

||||

[_timer addToRunLoop:[NSRunLoop mainRunLoop] forMode:NSRunLoopCommonModes]; |

||||

[_timer setPaused:NO]; |

||||

|

||||

[self.demuxer startReading:^(BOOL success, NSError * _Nonnull error) { |

||||

NSLog(@"KFMP4Demuxer start:%d", success); |

||||

}]; |

||||

} |

||||

|

||||

- (void)dealloc { |

||||

|

||||

} |

||||

|

||||

#pragma mark - Setup |

||||

- (void)setupUI { |

||||

self.edgesForExtendedLayout = UIRectEdgeAll; |

||||

self.extendedLayoutIncludesOpaqueBars = YES; |

||||

self.title = @"Audio Render"; |

||||

self.view.backgroundColor = [UIColor whiteColor]; |

||||

|

||||

|

||||

// Navigation item. |

||||